一文读懂大模型训练全流程:从文本到智能的7个关键步骤

本文详细解析了大语言模型的完整训练流程,包括输入处理(分词、嵌入、位置编码)、解码器层结构(多头自注意力与前馈网络)、输出预测、反向传播,以及监督微调(SFT)、奖励建模(RM)和强化学习(PPO+RLHF)三阶段对齐技术。同时介绍了DPO替代方案及工程细节,揭示了GPT、Llama等模型从语言建模到人类对齐的技术演进。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

在人工智能浪潮中,大语言模型(LLM)已成为核心基础设施。但你是否真正理解:一个模型是如何从一段普通文本,一步步“学会说话”的?本文将带你深入大模型的训练全流程——从初始化、前向传播、损失计算,到反向传播、微调与对齐——用清晰的逻辑链条和专业术语,还原 GPT、Llama、DeepSeek 等主流模型背后的工程真相。

一、输入阶段:从文本到向量

一切始于一段原始文本,比如:“今天天气真好”。

1. Tokenization(分词)

首先,模型通过 Tokenizer 将文本切分为离散的 token。例如:

"今天天气真好" → [tok_今, tok_天, tok_气, tok_真, tok_好]

2. Embedding(嵌入)

每个 token 被映射为一个 d_model 维的向量(如 4096 维),这个过程由可学习的 Embedding 矩阵 完成:

- 形状:

(vocab_size, d_model) - 每个 token 对应一行向量

3. Positional Encoding(位置编码)

由于 Transformer 本身不具备顺序感知能力,需加入 位置信息。现代主流采用 RoPE(Rotary Position Embedding):

- RoPE 使用旋转矩阵 $ R_m $,基于 cos cos cos 和 sin sin sin 函数构建

- 仅作用于 Query (Q) 和 Key (K) 向量,Value (V) 不加

- 相比传统绝对位置编码,RoPE 更擅长处理 长序列外推 和 相对位置关系

- 超参数

base=10000可动态调整(如 Llama 3 支持动态缩放)

最终,每个 token 的表示变为:

x = embedding(token) + positional_encoding(position)

二、Decoder 层内部:多头自注意力 + 前馈网络

Transformer 的核心是堆叠多个 Decoder 层(GPT 系列无 Encoder)。每层结构如下(以 Pre-LN 架构 为主流):

x → LayerNorm → MultiHeadAttention → Residual Add (x + attn_output) → LayerNorm → FeedForward Network (FFN) → Residual Add → output

1. 多头自注意力机制(Multi-Head Self-Attention)

(1)线性投影:生成 Q, K, V

对输入向量 $ x in mathbb{R}^{d_{ ext{model}}} $,通过三个可学习权重矩阵:

-

$ W_Q, W_K, W_V in mathbb{R}^{d_{ ext{model}} imes d_k} $

-

实际实现中,PyTorch 的

nn.Linear包含 Weight 和 Bias 两个独立张量: -

weight: (out_features, in_features) -

bias: (out_features,)(注意:不是

(in, out)!)

⚠️ 注:在 Pre-LN 架构中,LayerNorm 后常省略 Bias,便于优化。

(2)计算注意力分数

对每个 head: $ ext{Attention}(Q, K, V) = ext{softmax}left( rac{QK^T}{sqrt{d_k}} ight) V $

- $ QK^T $ 衡量 token 之间的相关性

- 每个 token 作为“中心主题”,对其他 token 的 V 进行加权求和

(3)多头聚合

假设有 $ h $ 个 head(如 32),每个 head 输出维度为 $ d_k = d_{ ext{model}} / h $。

将所有 head 拼接后,通过 输出投影矩阵 $ W_O $ 聚合:

-

$ W_O in mathbb{R}^{(h cdot d_k) imes d_{ ext{model}}} = mathbb{R}^{d_{ ext{model}} imes d_{ ext{model}}} $

-

本质仍是

nn.Linear,作用包括: -

维度对齐

-

(确保输出与输入同维)

-

增强表达能力(通过升维+非线性)

-

解耦特征空间(不同任务可用不同投影)

2. 前馈网络(Feed-Forward Network, FFN)

FFN 是两层线性变换 + 激活函数(通常为 SwiGLU 或 ReLU):

- 第一层:$ W_1 in mathbb{R}^{d_{ ext{model}} imes (4 cdot d_{ ext{model}})} $,升维放大特征

- 第二层:$ W_2 in mathbb{R}^{(4 cdot d_{ ext{model}}) imes d_{ ext{model}}} $,降维回原空间

💡 为何是 4 倍?这是经验设定(如原始 Transformer),现代模型可能调整(如 Mixtral 用 MoE)。

三、输出预测与训练目标

经过 N 层 Decoder 后,得到每个位置的上下文向量。仅取最后一个 token 的输出(因果语言建模):

- 通过 共享权重的 Embedding 矩阵 投影到词表空间: $ ext{logits} = h_{ ext{last}} cdot W_{ ext{embed}}^T $

- 再经 Softmax 得到下一个 token 的概率分布

✅ 共享 Embedding 与输出层权重,可减少参数、提升泛化(Press & Wolf, 2017)

训练方式:Teacher Forcing

- 输入序列

[x1, x2, ..., xn] - 目标:预测

[x2, x3, ..., x_{n+1}] - 一次性计算整个序列的交叉熵损失(而非逐 token)

四、反向传播:让模型“自省”

计算总 loss 后,启动 反向传播:

- 从最后一层的 $ W_2 $ 开始,逐层更新所有可学习参数($ W_Q, W_K, W_V, W_O, W_1, W_2, ext{Embedding} $ 等)

- 每次迭代,模型更“聪明”一点

- 完成全部训练数据的一轮遍历 = 1 epoch

此时模型已掌握语言统计规律,但尚不能可靠完成任务——它只是“会接话茬”。

五、对齐人类意图:后训练三阶段

阶段 1:监督微调(SFT, Supervised Fine-Tuning)

- 使用高质量 指令-回答对(如 Alpaca、ShareGPT)

- 学习格式、思维链(Chain-of-Thought)、代码等

- 模型开始具备“任务意识”

阶段 2:奖励建模(Reward Modeling, RM)

- 收集人类对同一问题多个回答的 偏好排序(Pairwise Ranking)

- 训练一个 Reward Model 来模拟人类打分

- 输入回答 → 输出标量奖励值

阶段 3:强化学习(PPO + RLHF)

-

使用 PPO(Proximal Policy Optimization) 优化策略

-

Loss 包含两项:

-

奖励最大化

-

:鼓励高 RM 分数的回答

-

KL 散度惩罚:防止偏离 SFT 模型太远(避免胡说八道)

-

这就是 RLHF(Reinforcement Learning from Human Feedback)

🔥 OpenAI 的核心绝招:SFT + (RM + PPO) 循环迭代

六、替代方案:DPO(直接偏好优化)

并非所有公司都能跑通复杂的 RLHF。于是 DPO(Direct Preference Optimization) 应运而生:

- 无需训练 Reward Model

- 直接利用偏好数据(一个 prompt + 两个回答:chosen vs rejected)

- 通过优化策略,拉高 chosen 回答的概率,压低 rejected 的概率

- 数学上等价于隐式优化奖励函数,但训练更稳定、高效

📌 Llama 3.1 就进行了 6 轮 DPO 循环,持续提升对齐效果。

七、工程细节补充

| 模块 | 关键点 |

|---|---|

| RoPE | 仅用于 Q/K;支持长文本外推;Llama 3 动态调整 base |

| LayerNorm 位置 | 原始论文:Post-LN;现代主流:Pre-LN(更稳定) |

| 参数存储 | PyTorch 中 weight 与 bias 独立存储,便于优化 |

| 模型差异 | DeepSeek 优化计算效率(牺牲精度);Llama/GPT 训练流程一致,后训练策略不同 |

结语

大模型的训练,是一场从 语言建模 到 人类对齐 的长征。

预训练赋予它“知识”,SFT 赋予它“能力”,RLHF/DPO 赋予它“价值观”。

理解这一流程,不仅能看懂技术报告,更能洞察 AI 发展的本质逻辑——不是魔法,而是工程、数据与算法的精密交响。

延伸思考:未来是否会出现无需 RLHF 的对齐范式?DPO 会取代 PPO 吗?欢迎在评论区讨论!

参考文献

- Vaswani et al., Attention Is All You Need, 2017

- Christiano et al., Deep Reinforcement Learning from Human Preferences, 2017

- Rafailov et al., Direct Preference Optimization, 2023

- Touvron et al., Llama 3 Technical Report, 2024

被公众号格式兼容性差表示烦躁的一天😡

今天笔记信息量有点大,我也消化了好久

好好学习,天天向上。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

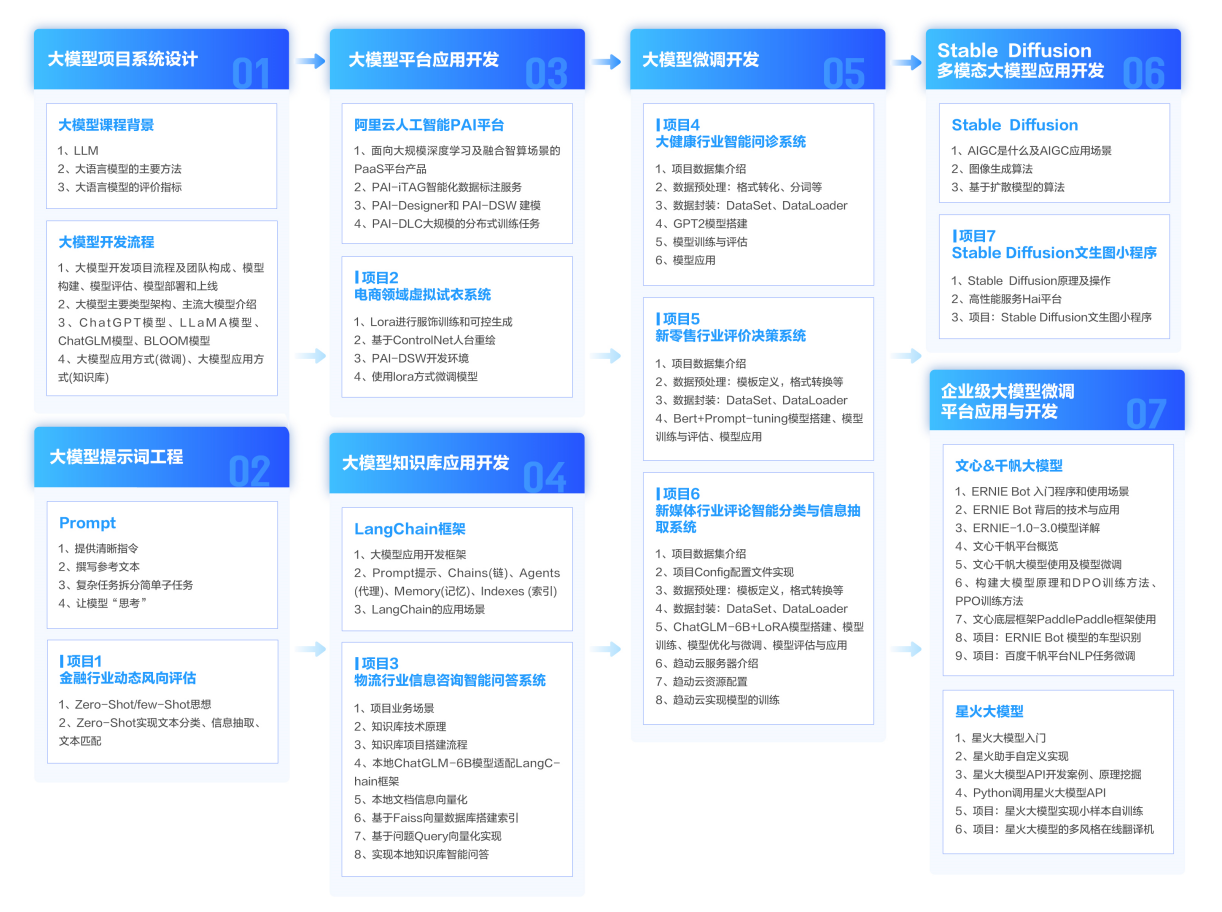

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓