在centos下离线安装ollama和DeepSeek

视频链接:在centos离线安装ollama和deepseek_哔哩哔哩_bilibili

一、下载安装ollama

wget https://github.com/ollama/ollama/releases/download/v0.5.11/ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

ollama serve二、增加ollma用户和组

1、确保 ollama 用户和组存在

systemd 服务要求 User=ollama 和 Group=ollama 必须存在于系统中。如果未创建该用户和组,服务会因找不到用户而失败。

# 创建 ollama 用户和组

sudo groupadd ollama

sudo useradd -g ollama -s /usr/sbin/nologin ollama

# 验证用户和组是否存在

id ollama # 应显示用户信息2. 检查 /usr/bin/ollama 的权限

确保 ollama 二进制文件对 ollama 用户可执行,且路径正确。

# 检查 ollama 是否在 /usr/bin 下

ls -l /usr/bin/ollama

# 如果不存在,重新安装或修复路径

sudo cp /path/to/ollama /usr/bin/ # 手动复制到正确路径

# 赋予 ollama 用户执行权限

sudo chown ollama:ollama /usr/bin/ollama

sudo chmod 755 /usr/bin/ollama3. 检查模型存储目录权限

Ollama 默认会将模型存储在 ~/.ollama(即 /home/ollama/.ollama),需确保 ollama 用户有读写权限。

# 创建存储目录并赋予权限

sudo mkdir -p /home/ollama/.ollama/models

sudo chown -R ollama:ollama /home/ollama/.ollama/models

sudo chmod 755 /home/ollama/.ollama/models

sudo chown -R ollama:ollama /home/ollama/.ollama

sudo chmod 755 /home/ollama/.ollama三、使用 systemd 服务实现以系统服务方式启动ollama

通过 systemd 可以将 Ollama 配置为系统服务,实现开机自启动和后台运行。以下是具体步骤:

1、创建服务文件

在 /etc/systemd/system/ 目录下创建 ollama.service 文件:

sudo vi /etc/systemd/system/ollama.service文件内容如下:

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="OLLAMA_MODELS=/home/ollama/.ollama/models"

[Install]

WantedBy=default.target

2、启动并启用服务

保存文件后,执行以下命令启动并启用服务:

# 重新加载服务配置

sudo systemctl daemon-reload

# 开机自启动

sudo systemctl enable ollama

# 立刻启动

sudo systemctl start ollama

# 重启服务

sudo systemctl restart ollama你可以通过以下命令检查服务状态:

sudo systemctl status ollama四、在线下载、离线上传DeepSeek模型

在能上网的电脑上下载DeepSeek:

ollama run deepseek-r1:7b

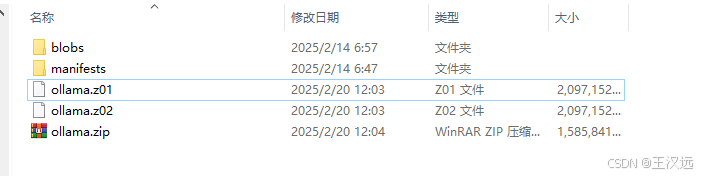

分卷压缩,比如压缩后的一堆名字是ollama.zip、ollama.z01、ollama.z02...。

上传到centos解压缩:

7za x ollama.zip如果centos上没有p7zip,还需要安装 p7zip 及其插件:

sudo yum install -y p7zip p7zip-plugins五、运行DeepSeek

ollama run deepseek-r1:1.5b