在Ubuntu22.04 配置安装Dify Ollma 以及Deepseek配置

在Ubuntu22.04 配置安装Dify Ollma 以及Deepseek配置

文章目录

- 在Ubuntu22.04 配置安装Dify Ollma 以及Deepseek配置

- 前言

- 一、安装docker以及docker compose

- 1. 更新软件包

- 2. 安装docker依赖

- 3. 添加docker密钥

- 4.添加阿里云docker软件源

- 5.安装docker和docker compose

- 6.配置用户组(非必须操作,此操作目的是为了以后执行docker命令时无需输入sudo密码,避免这些重复操作而已。)

- 7.重启电脑

- 8. docker 换源

- 二、安装dify

- 三、安装ollama

- 四、配置Dify以及Ollama

- 1. 首次登陆Dify

- 2. 将本地大模型与Dify进行关联

- 总结

前言

随着人工智能的发展,deepseek是今年最火的开源大模型之一,他也促进了机器人整个行业的发展,最近在做一个项目,就涉及到用deepseek做一些应用。经过调研,决定搭建本地deepseek 7b的模型,结合Dify进行开发。但是在环境配置中,遇到很多问题,一开始电脑的系统是ubuntu20.04的,一直配置有点问题,所以后来和几个工程师小伙伴们讨论,决定采用ubuntu22.04的,于是,我们重装了一台全新的ubuntu22.04,在一个全新系统上进行安装。因此,我把安装记录写一下,方便也有此需求的小伙伴们可以参考。

提示:以下是本篇文章正文内容,下面案例可供参考

一、安装docker以及docker compose

根据dify的官网文档,我们还是决定采用docker安装,这样才不会影响系统其他环境的使用。

1. 更新软件包

sudo apt-get update

sudo apt-get upgrade

2. 安装docker依赖

sudo apt-get install ca-certificates curl gnupg lsb-release

3. 添加docker密钥

curl -fsSL http://mirrors.aliyun.com/docker-ce/linux/ubuntu/gpg | sudo apt-key add -

4.添加阿里云docker软件源

sudo add-apt-repository "deb [arch=amd64] http://mirrors.aliyun.com/docker-ce/linux/ubuntu $(lsb_release -cs) stable"

5.安装docker和docker compose

apt-get install docker-ce docker-ce-cli containerd.io docker-compose-plugin

6.配置用户组(非必须操作,此操作目的是为了以后执行docker命令时无需输入sudo密码,避免这些重复操作而已。)

sudo usermod -aG docker $USER

7.重启电脑

sudo reboot

重启电脑后,docker应该就会运行起来。但是,由于国内各种限制,所以导致我们需要更换docker方可实现容器的下载,经过多次测试,最终确定了几个源是可以用的,具体如下:

8. docker 换源

刚安装好的docker的电脑是没有/etc/docker/daemon.json这份文件的,所以,需要创建这个文件,在这里,我们直接用vim直接编辑,然后保存。

sudo vim /etc/docker/daemon.json

在文件里面输入以下内容

{

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://docker.1panel.live",

"https://hub.rat.dev",

"https://docker.mirrors.ustc.edu.cn/"

]

}

保存后,一定得先reload一次这份文件,然后再重启docker,否则会重启失败,这个坑我也搞了很久。。。具体如下:

sudo systemctl daemon-reload

sudo systemctl restart docker

二、安装dify

dify的安装过程较为简单,根据官方文档安装即可,具体如下:

git clone https://github.com/langgenius/dify.git

cd dify

cd docker

cp .env.example .env

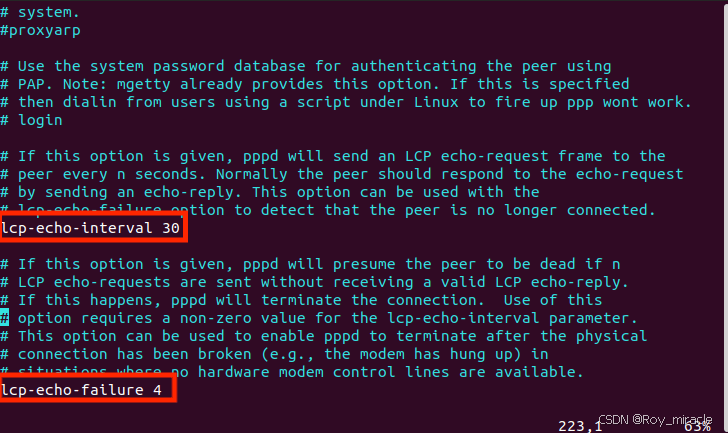

由于后期还需要配置dify以及本地的ollama,因为dify在用docker 容器安装的,ollama是装在本地的,因此,在.env文件的末端需要加入配置,否则无法dify无法访问本地的ollama,具体如下:

vim .env

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Olama 的 API地址(根据部署环境调整IP)

OLLAMA_API_BASE_URL=http://host.docker.internal:11434

PLUGIN_WORKING_PATH=/app/cwd

修改保存后,就可以开始运行dify了。

docker compose up -d

关于指令是docker compose 还是 docker-compose 也困扰了我一阵,经过查找,才知道是docker compose 的版本问题,或者说是docker compose的安装方法问题,因此,大家不必在此纠结,二者均可使用。

如果在安装过程中,发现类似于以下错误:

docker compose up -d

[+] Running 1/40

⠹ api [⠀⠀⠀⠀⠀⠀⠀⠀⠀⠀⠀⠀⠀] Pulling 27.3s

⠹ db Pulling 27.3s

⠹ nginx [⠀⠀⠀⠀⠀⠀] Pulling 27.3s

⠹ ssrf_proxy Pulling 27.3s

⠹ worker Pulling 27.3s

⠹ sandbox Pulling 27.3s

⠹ web Pulling 27.3s

⠹ redis [⠀⠀⠀⠀⠀⠀⠀] Pulling 27.3s

⠹ plugin_daemon [⠀⠀⠀⠀] Pulling 27.3s

✘ weaviate Error Get "https://registry-1.docker.io... 27.3s

Get "https://registry-1.docker.io/v2/": context deadline exceeded (Client.Timeout exceeded while awaiting headers)

那就是说明下载超时,这里有几个办法,如下:

- 由于网络不稳定的问题,你可以一直重复docker compose up -d试一下,看看有没有机会下载完成。

- 如果还是不行,只能尝试着在此换源,看看是否可以。

- 如果还是不行,只能试着让终端翻墙,看看是否可以。

- 如果还是不行,那就得怀疑是不是docker版本问题了。今天是2025年3月2号,前几天我一直下载都是失败,原因是在docker-compose.yaml文件中,下载的web是1.0.0的版本,内容如下:

# Frontend web application.

web:

image: langgenius/dify-web:1.0.0

...

但是前几天这个版本是找不到的,无论你换哪个源,所以我后来把版本换掉就可以下载了。但是今天我查看dify官网

两天前刚刚发布。。。所以今天下载就成功了。因此,dify的版本更新还是比较频繁的,我不确定看我博客的小伙伴们是哪天下载的,如果实在是docker安装一直失败,那就试试之前的版本,说不行就成功了。

三、安装ollama

如果一切正常,运行如下指令即可安装好ollama

curl -fsSL https://ollama.com/install.sh | sh

但是,大家在国内,你知道的,如果没有那啥啥啥的话,github往往给你出幺蛾子,你可能会有如下报错

curl: (56) OpenSSL SSL_read: error:0A000126:SSL routines::unexpected eof while reading, errno 0

你懂的,这时候你需要梯子且你的终端也可以用梯子出去。博客https://blog.csdn.net/linqiaqun/article/details/144894762中提到了一些方法,但是我觉得太麻烦了,之前遇到github超时无法下载,最简单暴力的方式,就是不断的运行,直到可以下载,因此,在这里我也用同样的方法,果然让我搞定了。。。还是暴力美学解决一切啊。。。

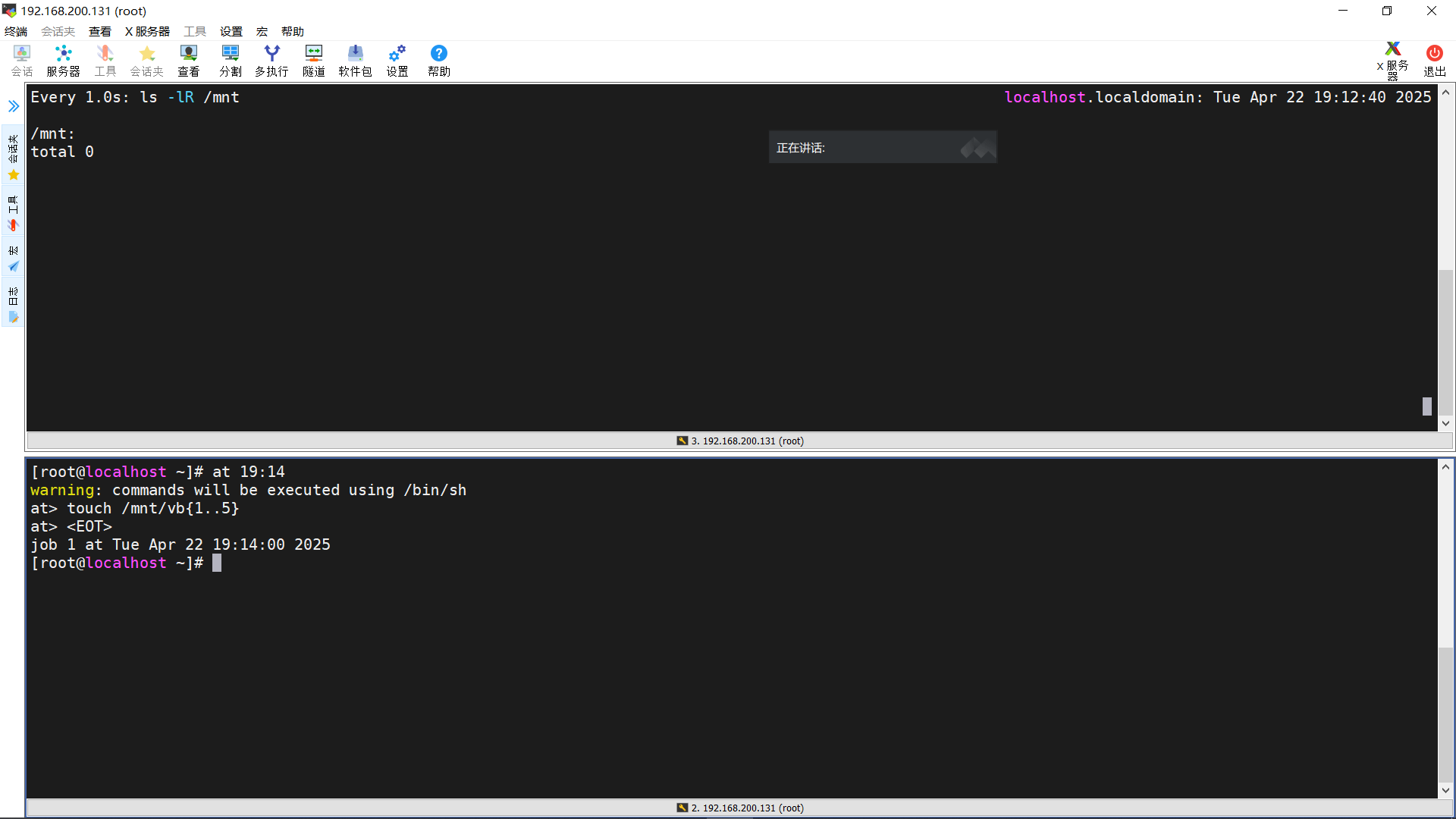

这时候就可以安装大模型了,在这里我们选择了deepseek-r1:7b模型,因此可以运行如下:

ollama run deepseek-r1:7b

四、配置Dify以及Ollama

1. 首次登陆Dify

- 在浏览器地址栏中输入“http://localhost/install”,首次安装,需要设置,如下图:

设置好了以后,就可以登录了。

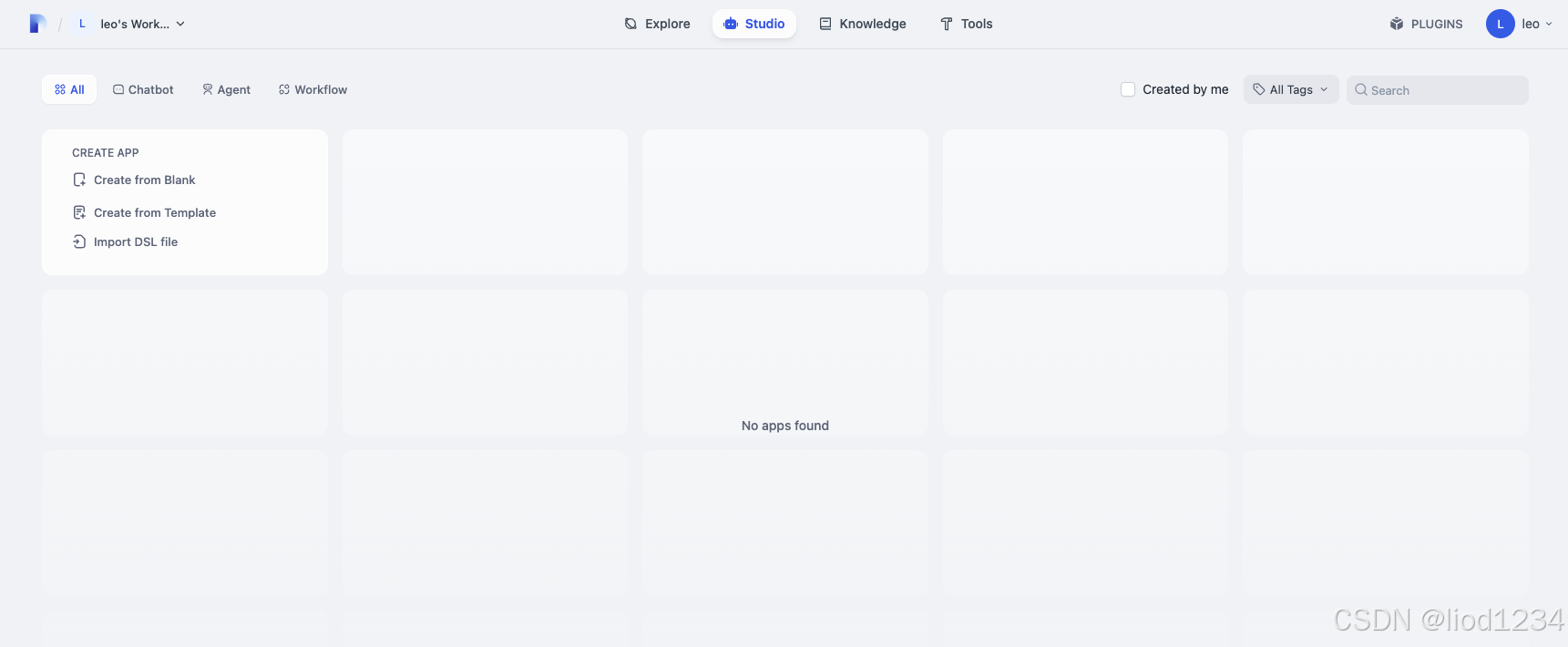

2.登陆成功进入主页,如下图:

2. 将本地大模型与Dify进行关联

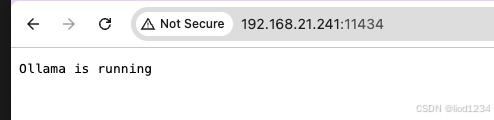

这个部分折腾我很长时间,包括一些环境变量配置啥的,首先,ollama无法外部访问,因此你需要配置环境变量,我是在Ubuntu22.04上安装的ollama,根据官方文档,需要对ollama.service进行配置,对于新安装的设备,是没有相关配置文件的以及路径的,因此具体执行如下:

sudo mkdir -p /etc/systemd/system/ollama.service.d/

sudo vim /etc/systemd/system/ollama.service.d/override.conf

创建好文件以后,写入如下:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

保存,然后重启ollama

sudo systemctl daemon-reload

sudo systemctl restart ollama

此时,你便可以用ip来访问ollama了,如下:

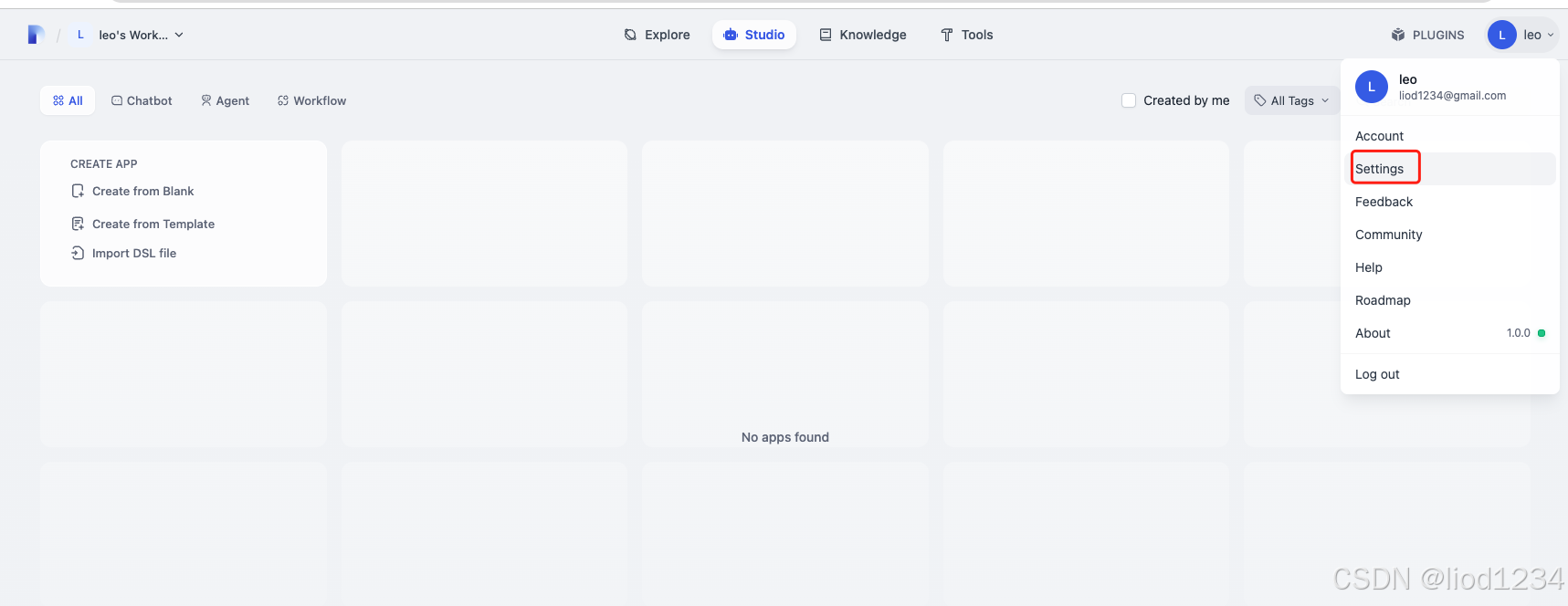

1)在Dify的主界面 http://localhost/apps ,点击右上角用户名下的【设置】

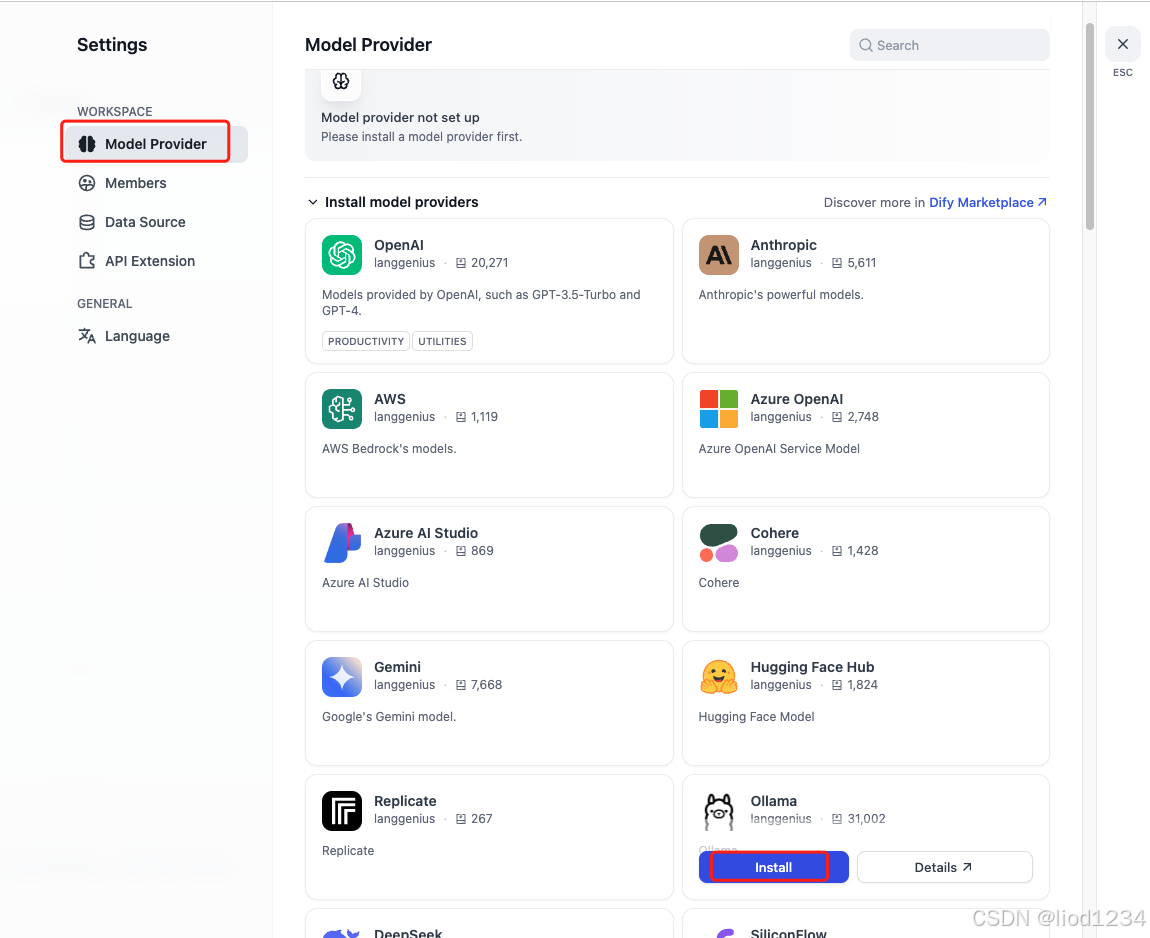

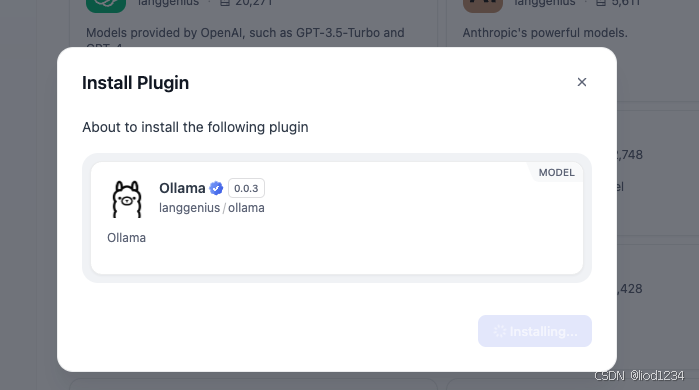

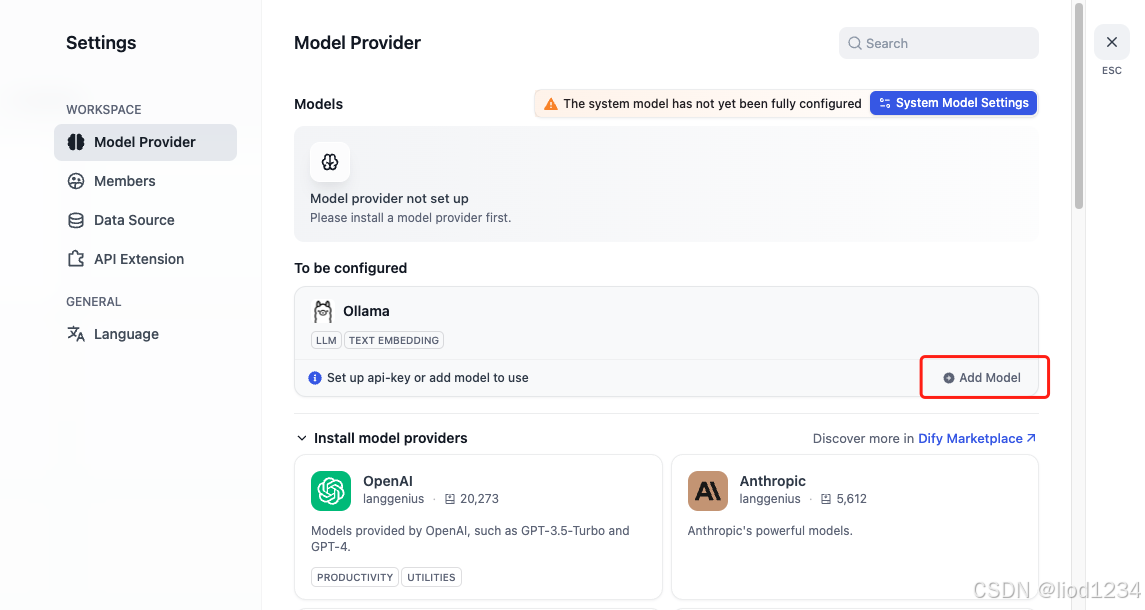

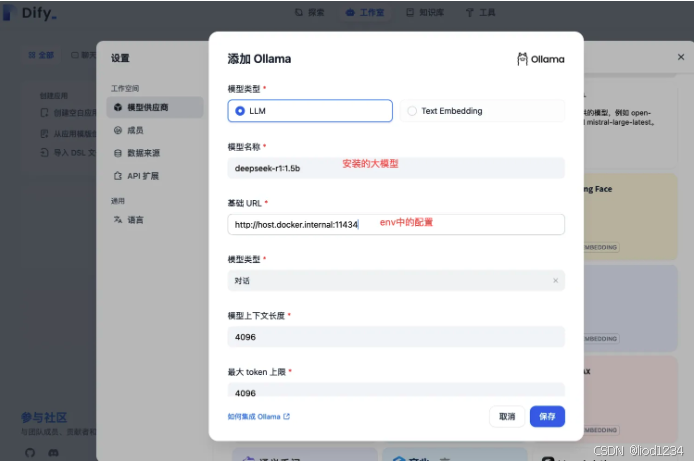

2)在设置页面–Ollama–添加模型,如下:

3)安装好了就可以关联模型了。

4)填写deepseek 模型信息相关信息后保存,如下:

总结

随着deepseek的深入应用,希望今天的这个博客可以帮助大家打开大模型应用的大门。