一文了解 GPU 服务器及其在数据中心中的角色

随着人工智能(AI)、大数据和高性能计算(HPC)的迅猛发展,传统的 CPU 服务器已难以满足日益增长的计算需求。GPU 服务器凭借其强大的并行处理能力,正逐步成为数据中心的核心计算引擎。

什么是GPU服务器?

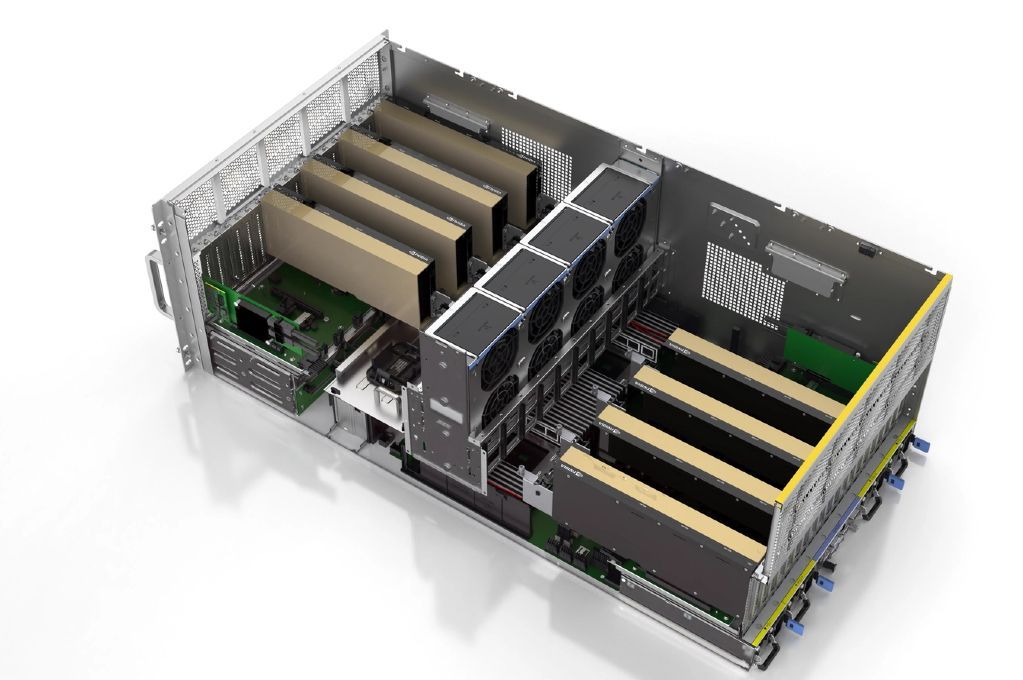

GPU服务器简单来说就是配备了一个或多个GPU的服务器。通常,GPU服务器承载需要大量并行计算能力的工作负载。由于GPU非常适合并行处理,它们在诸如训练AI模型等用例中表现出色,这类工作负载在执行大量并行操作时效果最佳。GPU服务器也包含中央处理器(CPU)。CPU对于执行传统计算任务是必需的,例如运行控制服务器的操作系统。但GPU服务器除了传统的CPU之外,还提供了GPU计算资源。

GPU服务器在数据中心中日益重要

在生成式AI热潮之前,数据中心内部很难见到GPU服务器。相反,大多数数据中心服务器都是传统设备,其计算资源仅由CPU提供。CPU对于驱动大多数类型的传统工作负载(如托管网站和数据库)非常出色。然而,随着对支持AI模型训练和推理的基础设施需求不断增长,承载GPU服务器的能力对数据中心来说变得越来越重要。

1. 加速 AI 和深度学习

在训练深度神经网络时,GPU 的并行计算能力显著缩短了训练时间。例如,CoreWeave 公司利用 NVIDIA GPU 构建的 AI 数据中心,为 OpenAI 提供了强大的算力支持。

2. 提升大数据处理能力

GPU 服务器能够高效处理大规模数据集,适用于实时数据分析、金融建模等高负载任务。其并行处理架构使得数据处理速度大幅提升。

3. 支持高性能计算(HPC)

在科学研究、工程模拟等领域,GPU 服务器提供了强大的计算能力,满足对高精度和高速度的双重需求。

4.降低能耗与成本

尽管 GPU 的初始投资较高,但其高效的计算能力和能耗比使得整体运营成本降低。此外,GPU 服务器的高密度部署也节省了数据中心的空间和能源。

GPU 服务器凭借高并行处理能力,可扩展性强,能效比高的优势,在各行各业都有广泛应用。

GPU服务器 vs. CPU服务器

在许多方面,GPU服务器与仅包含CPU的传统服务器相似。它们通常尺寸相同,可以安装到标准服务器机架中,并且需要相同类型的网络和电源连接。然而,GPU服务器在一些重要方面有所不同:

1.更多的扩展槽: 传统服务器通常包含相对较少的扩展槽,技术人员可用其将GPU和其他专用硬件设备连接到服务器主板上。这是因为大多数传统服务器不使用很多附加卡。但是,由于提供插入GPU的途径对GPU服务器至关重要,GPU服务器需要扩展槽——而且通常比传统服务器中的要多。有些GPU服务器拥有足以容纳多达10个独立GPU的插槽。

2.更高的电力需求: GPU消耗大量电力。这意味着GPU服务器必须能够提供比典型的纯CPU服务器更多的电力。电力输送到GPU的方式可能有所不同。在某些情况下,电力通过服务器主板提供,但高端企业级GPU有时会有专用的电源连接。然而,无论哪种方式,GPU服务器(以及承载它的机架)都需要能够提供足够的总输入能量来维持GPU运行。

3.更强的冷却能力: 高能耗伴随着高热输出。因此,GPU服务器必须特别擅长散热。它们可能需要比传统风扇更先进的冷却解决方案。

为GPU服务器准备数据中心

由于GPU服务器通常可以放置在传统的服务器机架中,从物理空间的角度来看,它们不会给数据中心运营商带来特殊的挑战。但数据中心可能需要在其他领域做出改变以适应GPU。其中最大的挑战或许在于电力领域。对于数据中心运营商来说,这不仅意味着要确保设施能够提供足够的电力来维持GPU服务器运行。对于那些不想让耗电量巨大的GPU破坏其可持续发展承诺的公司来说,投资可持续能源也可能成为优先事项。

同时,能够保持GPU服务器冷却也将是数据中心运营商的优先任务。如果没有能够非常高效散热的高级冷却系统,将数十台GPU服务器塞进一个机架可能不可行。

此外还有数据中心灾难恢复的问题。保护数据中心基础设施免受故障影响,并在故障发生时快速恢复,无论设施内部署的是何种类型的服务器,都十分重要,特别是配置高达数万元的多卡GPU服务器。故障恢复需全链路冗余方案,标准服务器替换策略完全失灵。

本文地址:https://www.vps345.com/13751.html