玩转 Deepseek ——第一篇、本地化部署(Windows+Ollama+Docker+OpenWebUI)

目录

第一章、需求分析

1.1 私有化部署Deepseek分析

1.1.1市场优势分析

1.1.2 技术优势分析

1.2 软硬件需求

第二章、部署步骤

2.1 Ollama 下载安装

2.1.1 Ollama 下载

2.1.2 Ollama 安装

2.1.3 Ollama 验证

2.2 Deepseek-r1 模型下载安装

2.2.1 Ollma 安装 deepseek-r1 模型

2.2.2 测试 deepseek-r1 模型

2.3 Docker下载安装

2.3.1检查安装环境

2.3.2 安装 Docker for Desktop

2.3.3 配置docker

2.4 OpenWebUI配置

2.4.1 启动 open-webui

2.4.2 功能测试:正常!

第三章、总结即下期规划

3.1 本次学习测试总结:

3.2 下期规划:

第一章、需求分析

1.1 私有化部署Deepseek分析

1.1.1市场优势分析

一、数据安全与隐私保护

-

数据自主掌控:所有数据存储于企业本地基础设施,企业可完全控制访问权限及安全策略,规避第三方云端数据泄露风险。

-

敏感信息防护:集成识别机制屏蔽敏感内容,满足政务、金融等强监管领域的安全合规需求。

二、成本优化

-

硬件成本降低:轻量化架构支持消费级GPU(如RTX 3090)运行,无需高端算力集群。

-

运营效率提升:推理优化技术降低30%-50%计算资源占用,减少能耗与长期订阅费用。

三、性能与效率提升

-

响应速度快:本地部署减少网络延迟,可实现每秒60词生成速度及毫秒级响应。

-

国产硬件适配:支持华为昇腾、海光等国产AI芯片,提升算力利用率。

四、业务连续性与稳定性

-

离线运行保障:外网中断时仍可维持核心业务运行,确保服务不中断。

-

资源灵活调度:根据业务需求动态分配算力,避免云服务资源闲置。

五、合规与灵活性

-

行业定制能力:支持参数调整、训练数据适配,满足政务、医疗等场景的个性化需求。

-

知识产权保护:本地部署避免技术方案与数据资产外流,减少供应商锁定风险。

典型应用:武汉市江夏区政务平台通过私有化部署实现AI全链路生产,内容生成效率提升3倍,错误率下降90%。

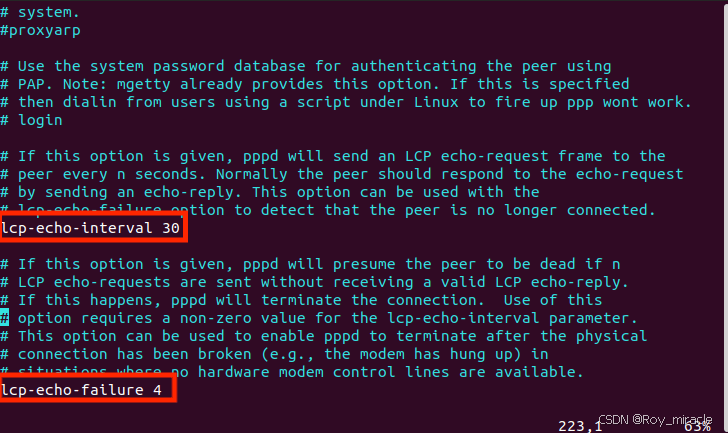

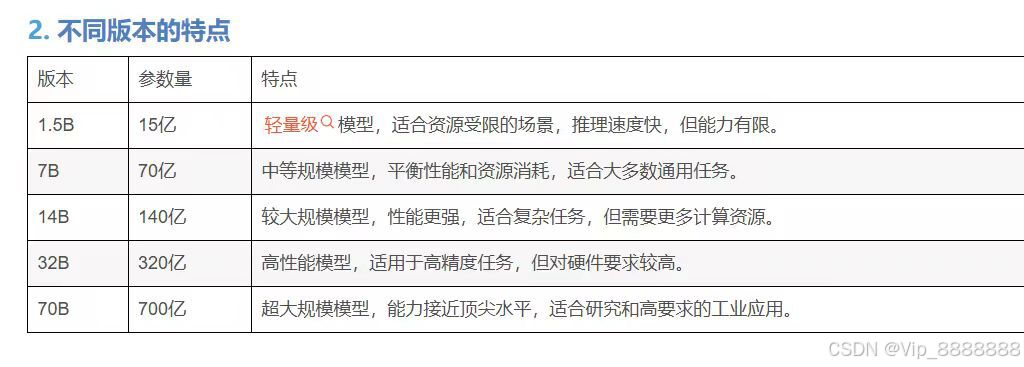

1.1.2 技术优势分析

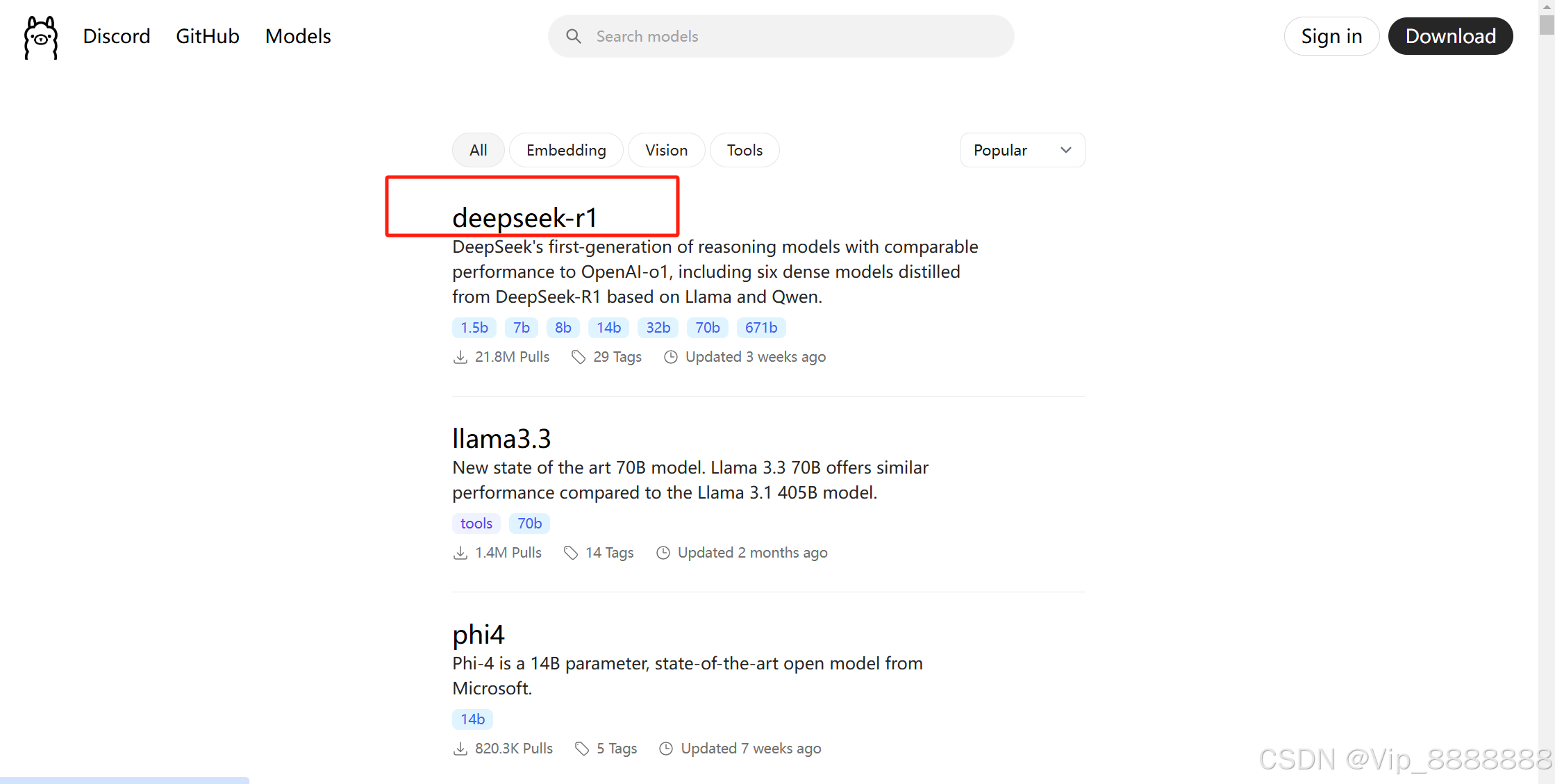

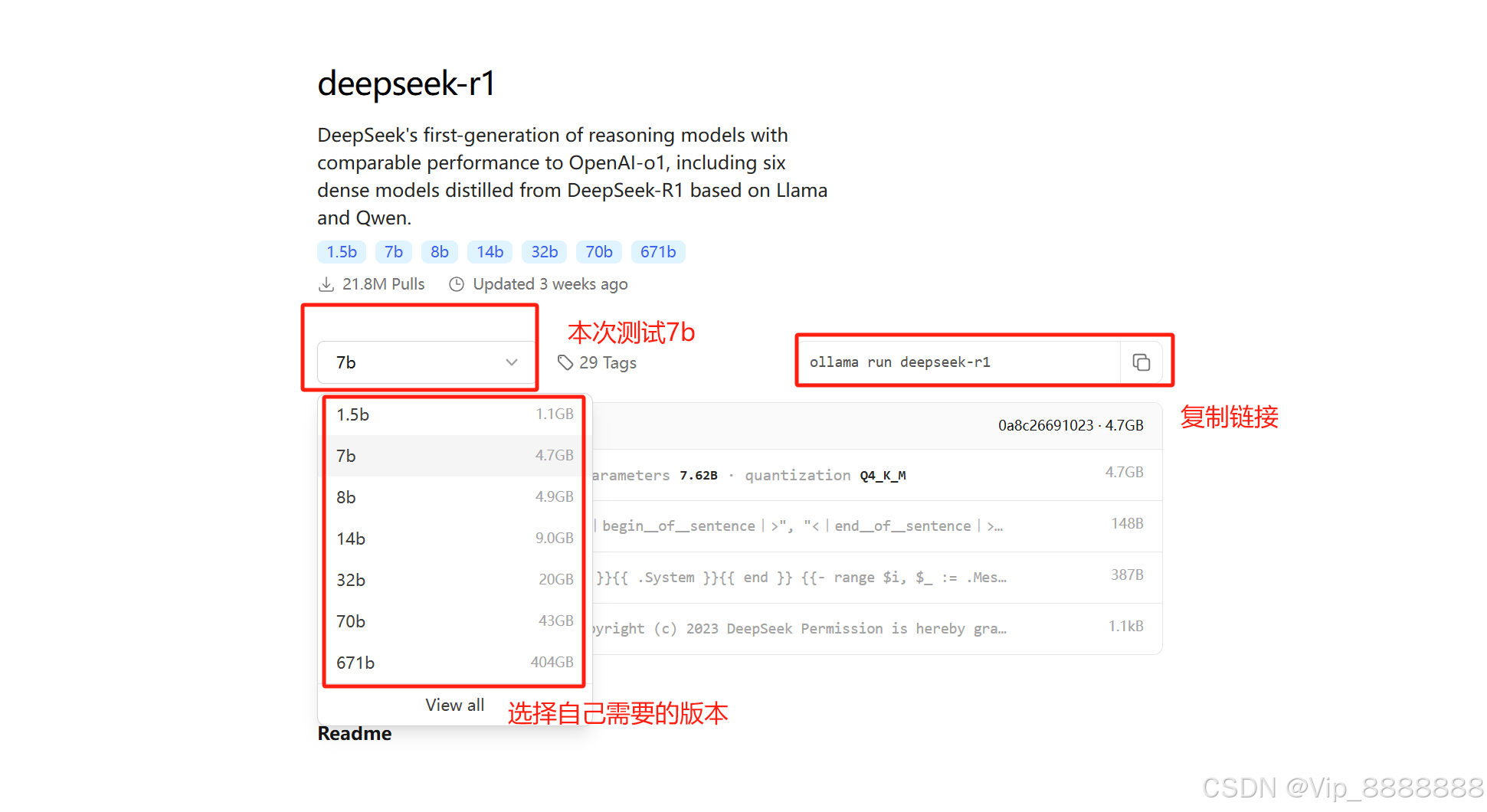

deepseek-r1 提供多个版本,参数量越大,模型的性能越强大,但也需要更多的存储和计算资源。

- 1.5b 模型参数为15亿/1.1GB,

- 7b 模型参数约为 70亿/4.7GB,

- 14b 模型参数约为 140亿/9GB。

- 等

用户可根据自身需求,部署适用于自身的deepseek模型,在保障安全性的条件下,有效提升工作效率,等优势。

1.2 软硬件需求

1.2.1 硬件需求

DeepSeek R1 本地部署的硬件需求如下:

基本推荐配置:CPU: 8核或以上,内存: 32GB或以上,存储: 100GB SSD或以上

GPU: NVIDIA GTX2080或同等性能

DeepSeek-7B 推荐配置:RTX3060 以上显卡 + 16G以上 内存 + 50G SSD 存储空间

DeepSeek-70B 推荐配置:RTX4060 以上显卡 + 32G以上 内存 + 200G SSD 存储空间

本教程使用的硬件配置为:

CPU: Intel i5-12490/3.00GHz

内存: 32GB

存储: 500GB SSD

GPU: NVIDIA GTX 3060。

1.2.2 软件依赖

DeepSeek R1 本地部署的软件依赖包括操作系统、容器化工具、编程语言、深度学习框架、数据库、消息队列、Web 服务器、GPU 加速工具、版本控制、包管理工具、监控与日志工具以及安全工具。

本教程采用 Windows10 操作版本、Python 3.8 版本、PyTorch 1.7 版本。

第二章、部署步骤

2.1 Ollama 下载安装

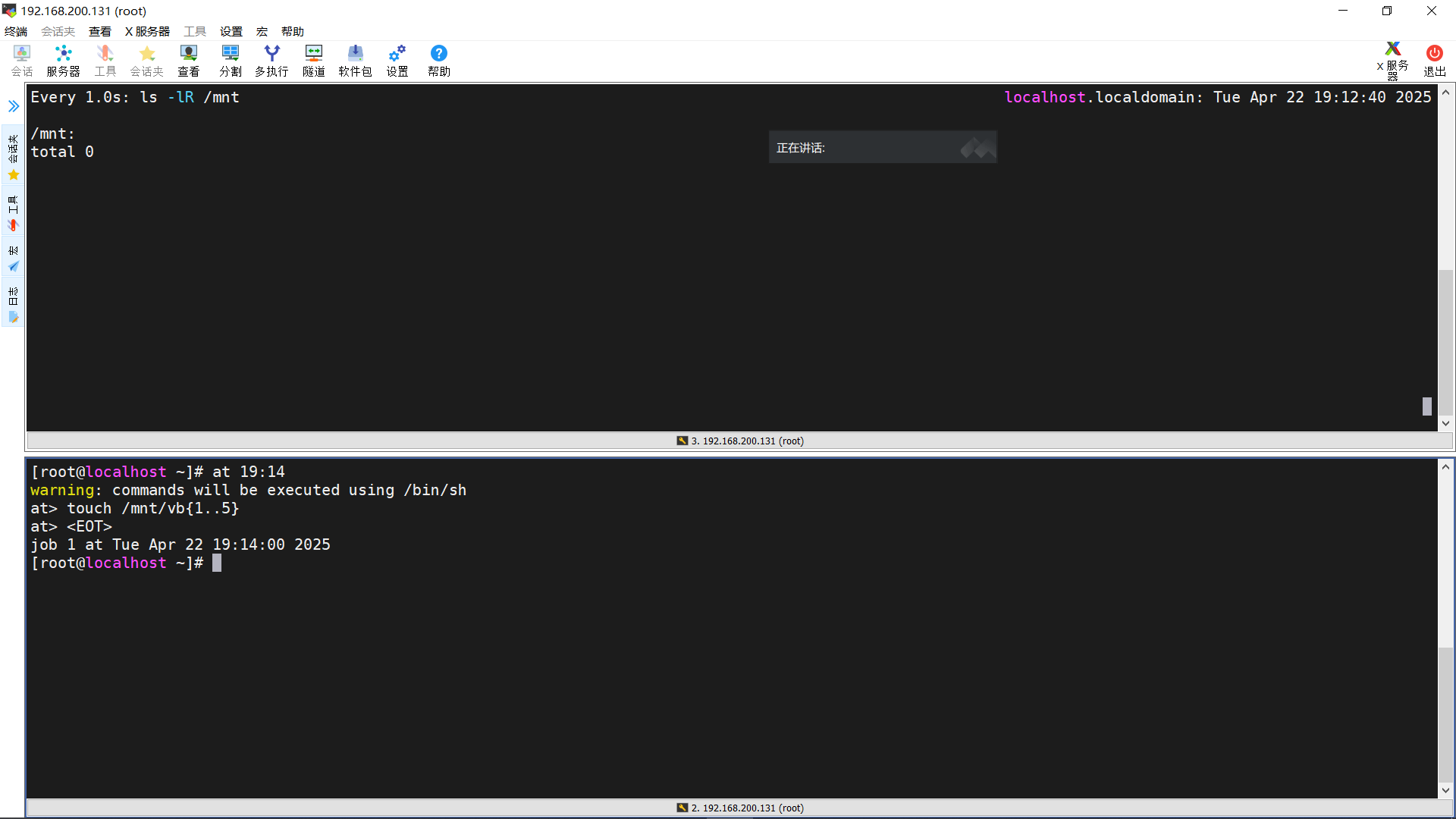

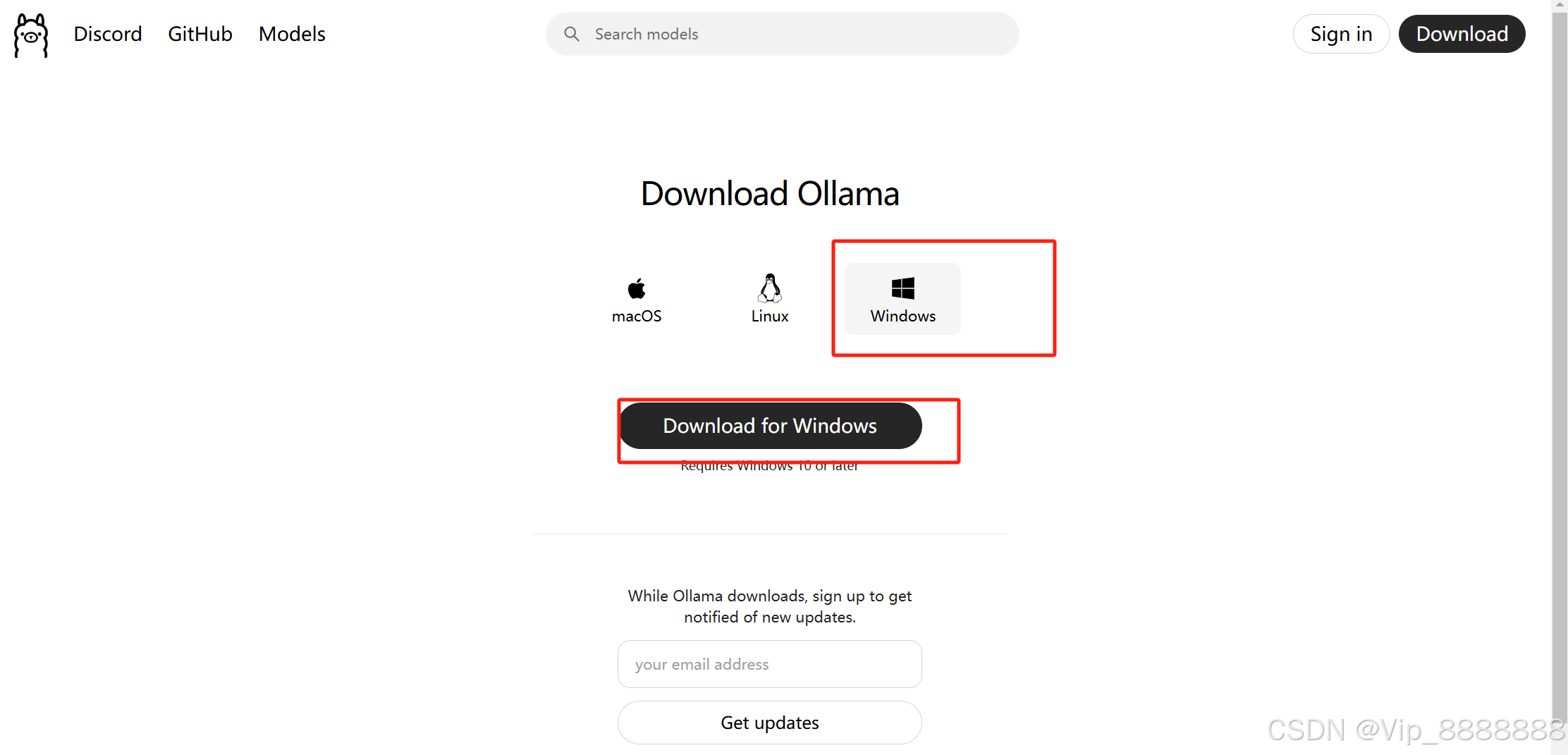

2.1.1 Ollama 下载

Ollama 是一个开源的本地模型运行工具,可以方便地下载和运行各种开源模型,如 Llama、Qwen、DeepSeek 等。

Ollama 提供高效、灵活的大模型部署和管理解决方案,可以简化模型的部署流程。支持macOS、Linux、Windows 操作系统。

官网地址:https://ollama.com/

下载地址:https://ollama.com/download

2.1.2 Ollama 安装

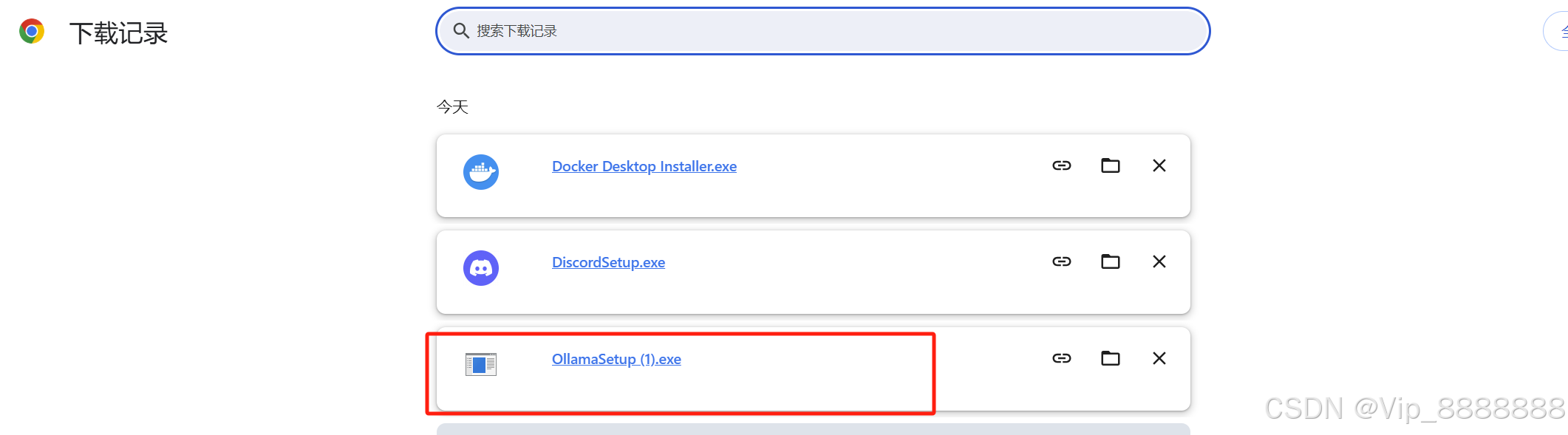

下载完成后直接点击 OllamaSetup.exe 进行安装。

安装完成后,cmd 打开命令行窗口,输入 “ollama -v” 测试,显示 ollama 的版本为 “0.5.12”,表明安装成功。

2.1.3 Ollama 验证

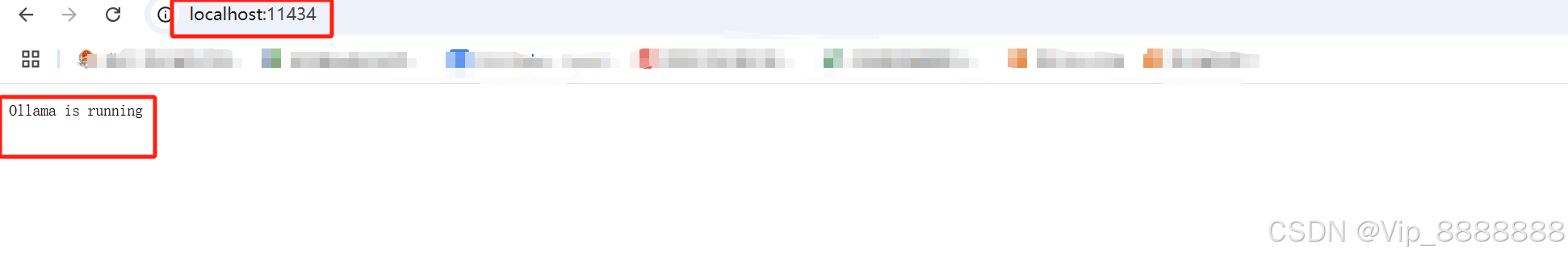

Ollama 没有用户界面,在后台会自动运行,重启电脑也会自动启动。

打开浏览器,输入 :

“http://localhost:11434/”,

显示 “Ollama is running”。

2.2 Deepseek-r1 模型下载安装

DeepSeek-R1,是幻方量化旗下AI公司深度求索(DeepSeek)研发的推理模型 。DeepSeek-R1采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务 。2024年11月20日,DeepSeek-R1-Lite预览版正式上线 。2025年1月20日,幻方量化旗下AI公司深度求索(DeepSeek)正式发布DeepSeek-R1模型,并同步开源模型权重。2025年1月31日,DeepSeek R1 671b已作为英伟达NIM微服务预览版发布。

2.2.1 Ollma 安装 deepseek-r1 模型

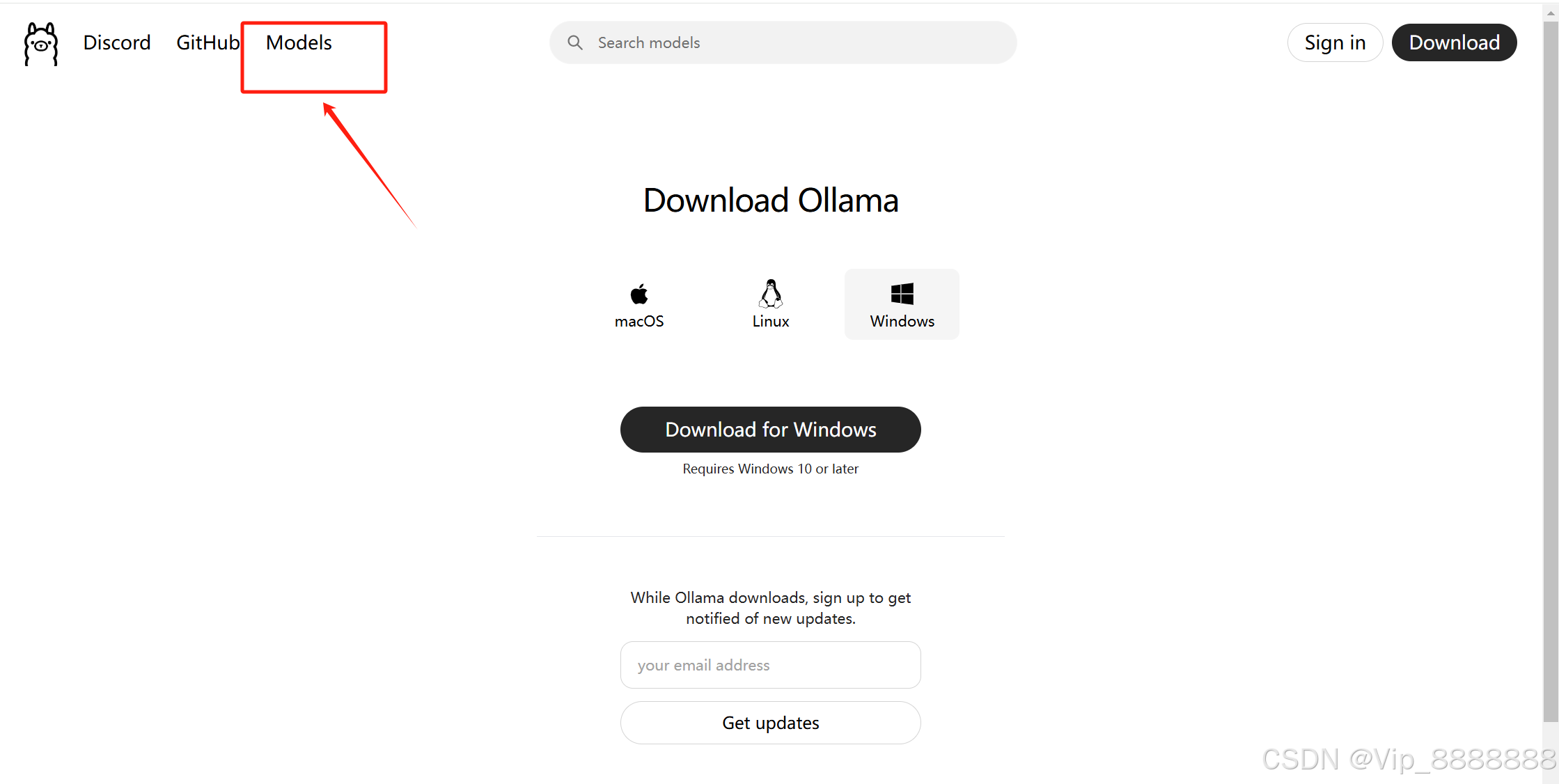

从 ollama 官网 查找 deepseek-r1 模型。(网址见:1.2.1章节)

2.2.1.1. 点击【Models】,跳转。

2.2.1.2. 点击【deepseek-r1】,跳转。

2.2.1.3. 选择自己需要的版本后复制链接内容。

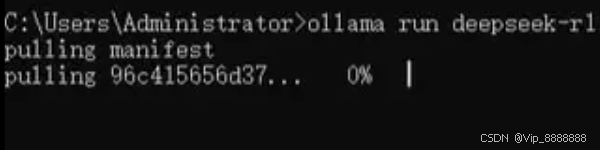

2.2.1.4. 本教程选择选择 7b 模型,在CMD命令行窗口运行安装命令 “ollama run deepseek-r1”,程序会自动下载和安装运行。

注:后面70%,进度较慢,需要等待!

默认地址是 “C:Users%username%.ollamamodels”。

如果要修改模型的保存地址,可以新建一个文件夹如 “C:Model”,然后在系统环境变量添加系统变量:

“变量名:OLLAMA_MODELS,

变量值:C:Model”。

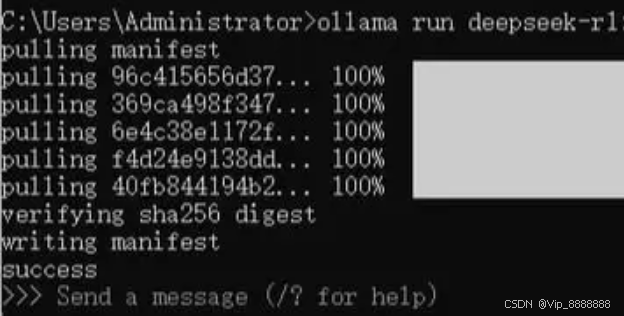

2.2.1.5. 出现【success】即安装成功!!

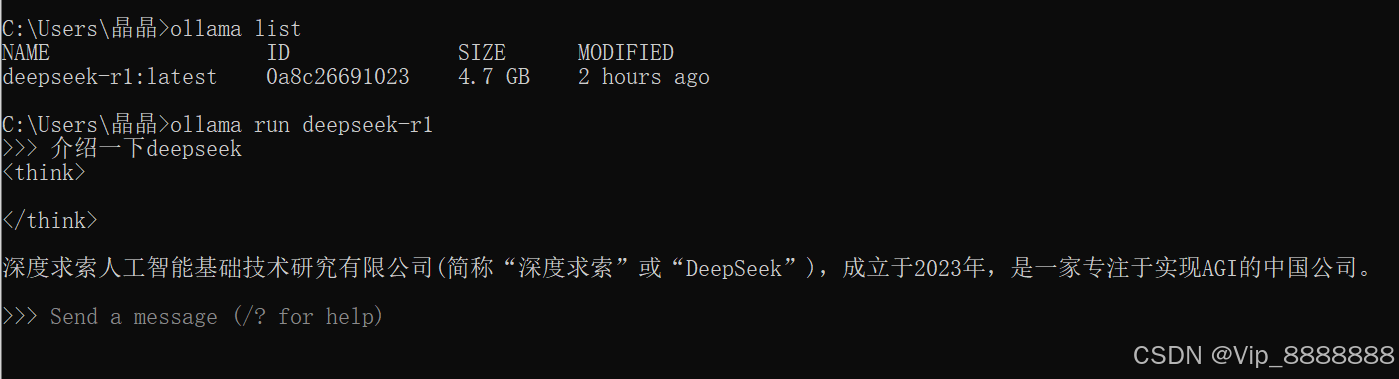

2.2.2 测试 deepseek-r1 模型

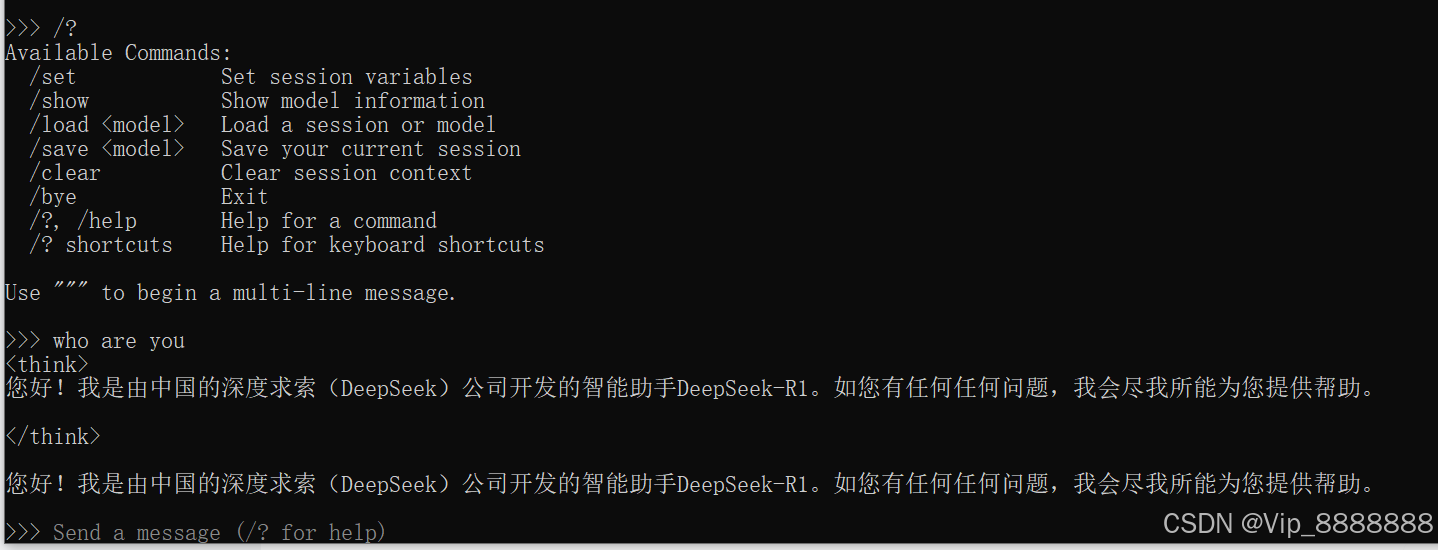

(1)在命令行窗口运行命令 “ollama run deepseek-r1:7b”,就可以在提示行输入,与 deepseek-r1 进行聊天。

(2)输入 “/?”,可以获得帮助。

%%: 通过本地命令行窗口可以使用 deepseek-r1,但这让人回到了 DOS 年代,交互体验很差。接下来我们按照 Docker 和 Open WebUI 用户界面,可以更便捷地使用 deepseek-r1。

2.3 Docker下载安装

Docker是一种虚拟化容器技术。Docker基于镜像,可以秒级启动各种容器。每一种容器都是一个完整的运行环境,容器之间互相隔离。

2.3.1检查安装环境

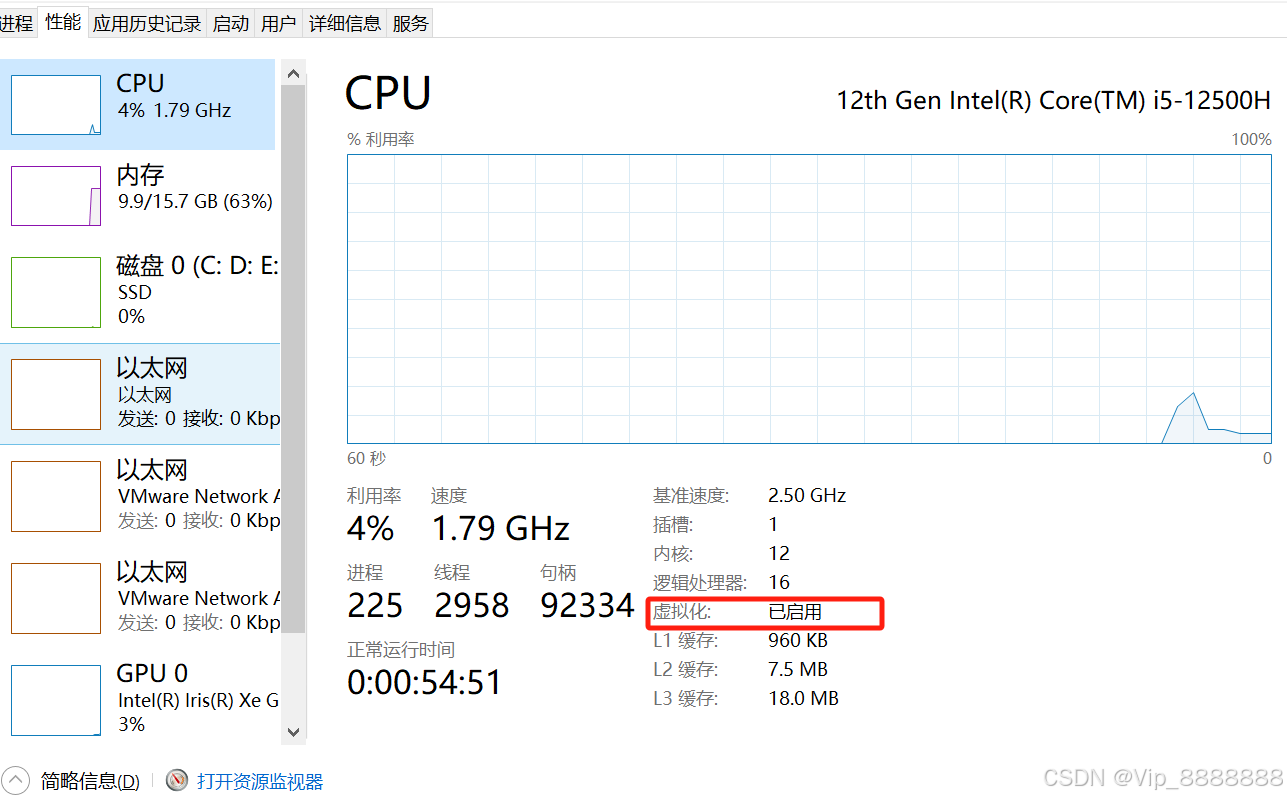

(1)在 Windows 任务管理器中,检查系统是否开启虚拟化。

打开任务管理器(Ctrl+Alt+Delete),选择:性能 - CPU - 虚拟化,确认“虚拟化”已启用。

未开启虚拟化解决方案:

如果未开启虚拟化,则要开机重启并进入BIOS 进行设置:在 BIOS 选择:Advanced(高级)-- CPU Configuration – Secure Virtual Machine,设置为:Enabled(启用)。

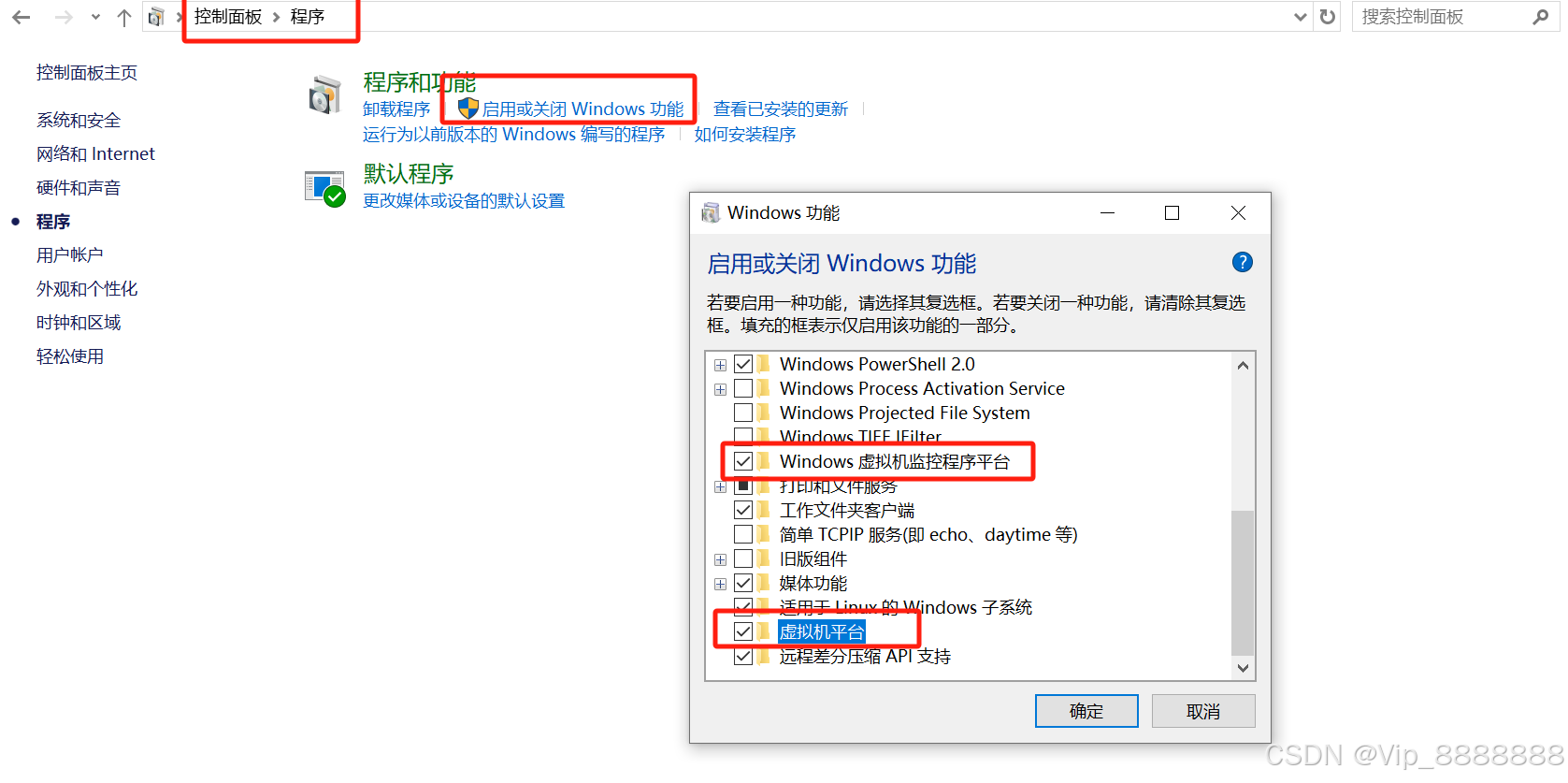

(2)在 “控制面板” 打开 “程序”,然后点击 “启用或关闭 Windows 功能”,勾选 “Hyper-V 管理工具” 和 “Hyper-V 平台”。

定义 Hyper-V - Training | Microsoft LearnHyper-V学习:定义 Hyper-V - Training | Microsoft Learn

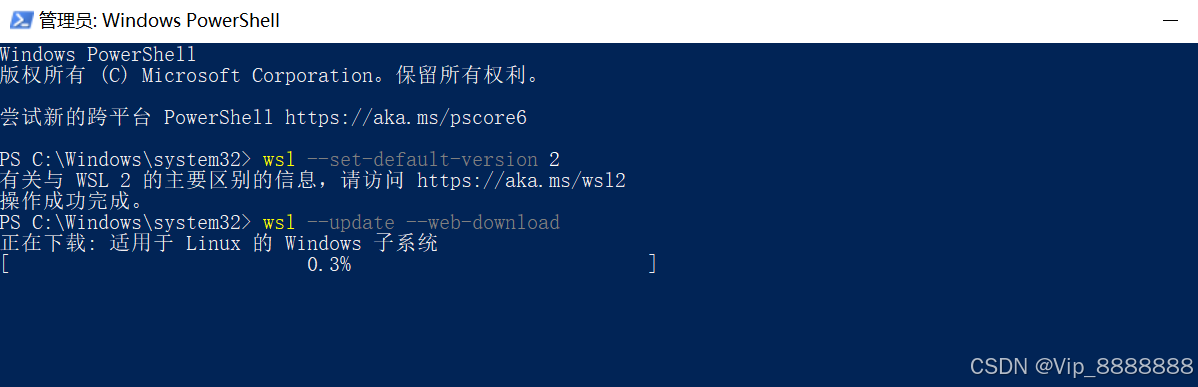

(3)以管理员身份打开命令行窗口,输入 “wsl --set-default-version 2”,将默认设置为 WSL 2。

通过适用于 Linux 的 Windows 子系统 (WSL),开发人员可以安装 Linux 发行版,并直接在 Windows 上使用 Linux 应用程序、实用程序和 Bash 命令行工具,不用进行任何修改。

命令行窗口,输入 “wsl --update --web-download”,更新安装 wsl。【管理员权限!!】

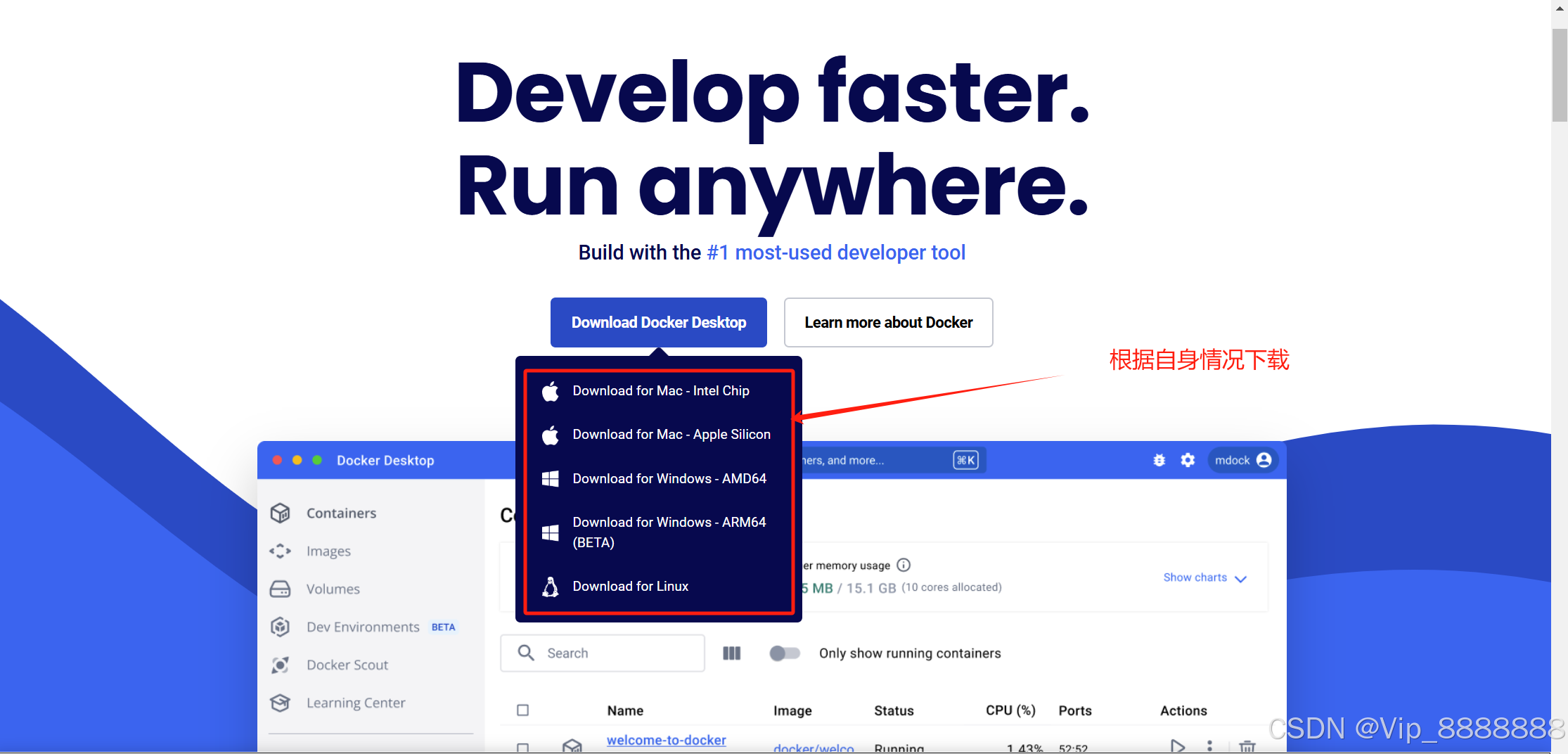

2.3.2 安装 Docker for Desktop

Docker Desktop 是 Docker 官方提供的桌面应用程序,旨在让开发者能够在 Windows 和 macOS 系统上轻松地构建、运行和共享容器化应用程序。Docker Desktop 提供了一个方便的工具集,使用户能够快速部署容器化应用程序,同时还包括了一些强大的功能和工具,如 Docker Engine、Docker CLI、Docker Compose 等。

(1)从 Docker 官方 下载 Docker 安装程序。

网址:Docker: Accelerated Container Application Development

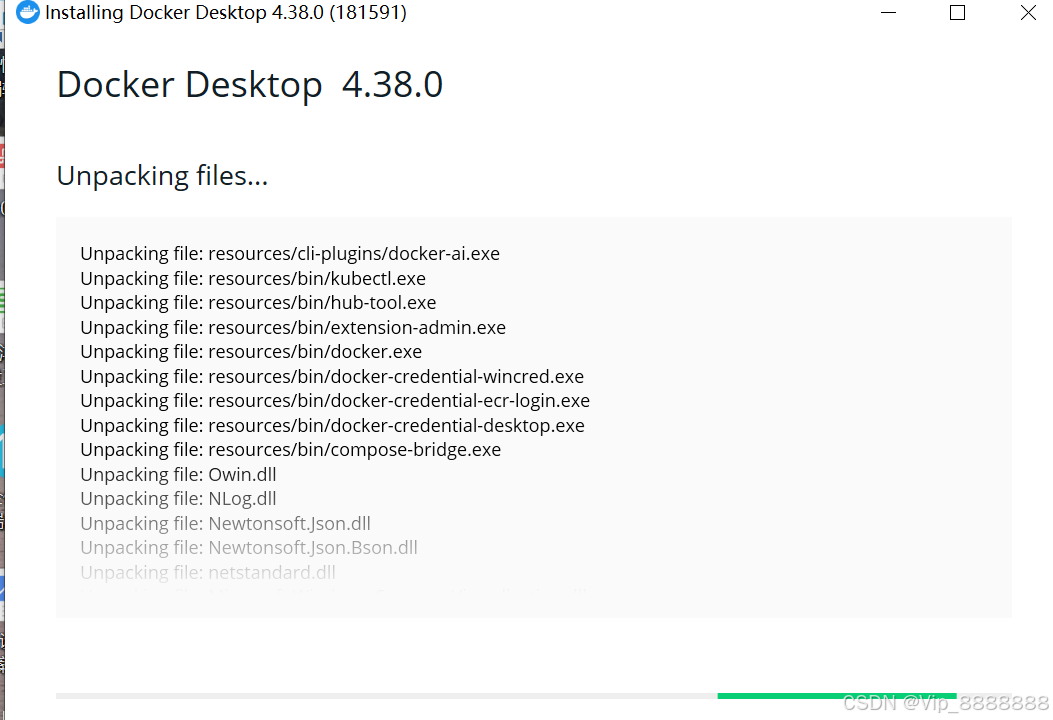

(2)运行安装包

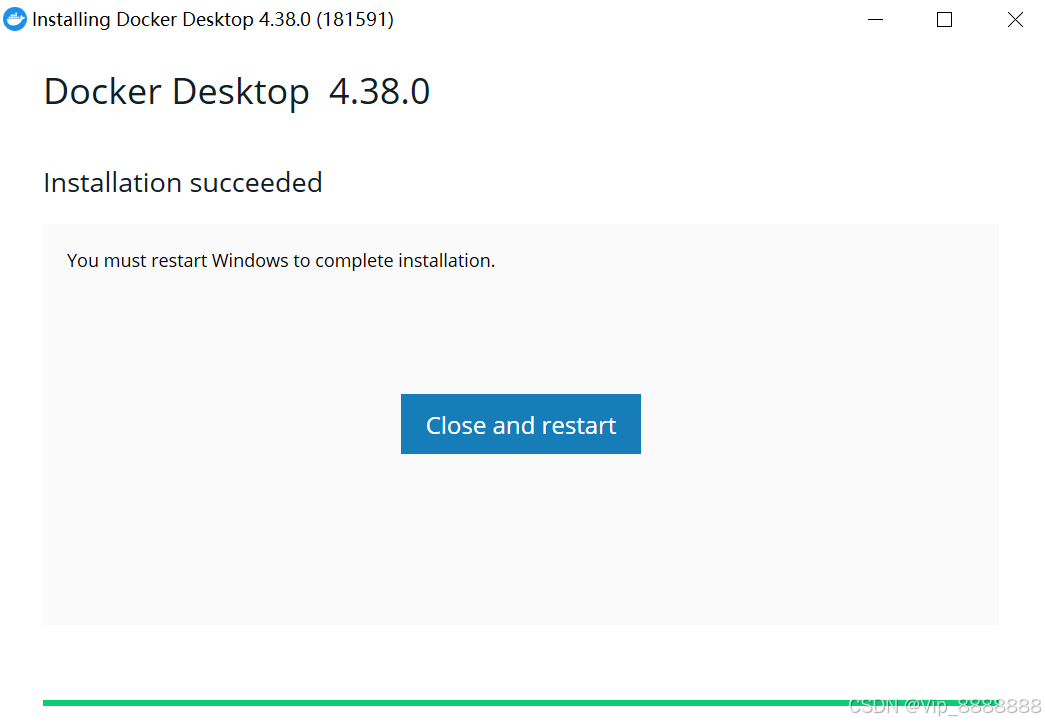

(3)安装完成后,cmd 打开命令行窗口,输入 “docker version” 检查

2.3.3 配置docker

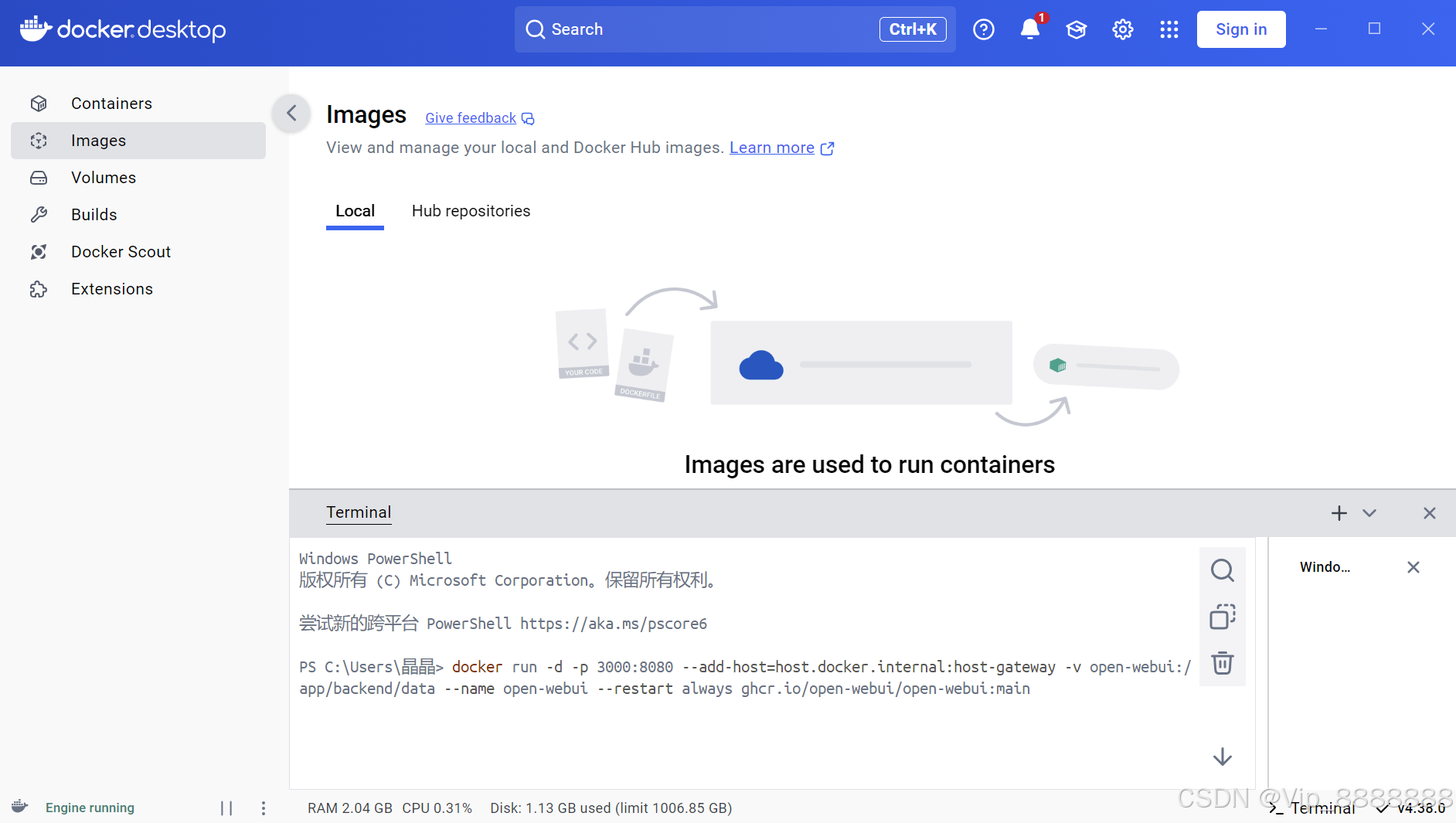

(1)安装完成后,我们打开docker,注册登录一下docker(可跳过),然后在右下角点击Terminal,打开控制台,然后输入下面命令,然后等待安装完成。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

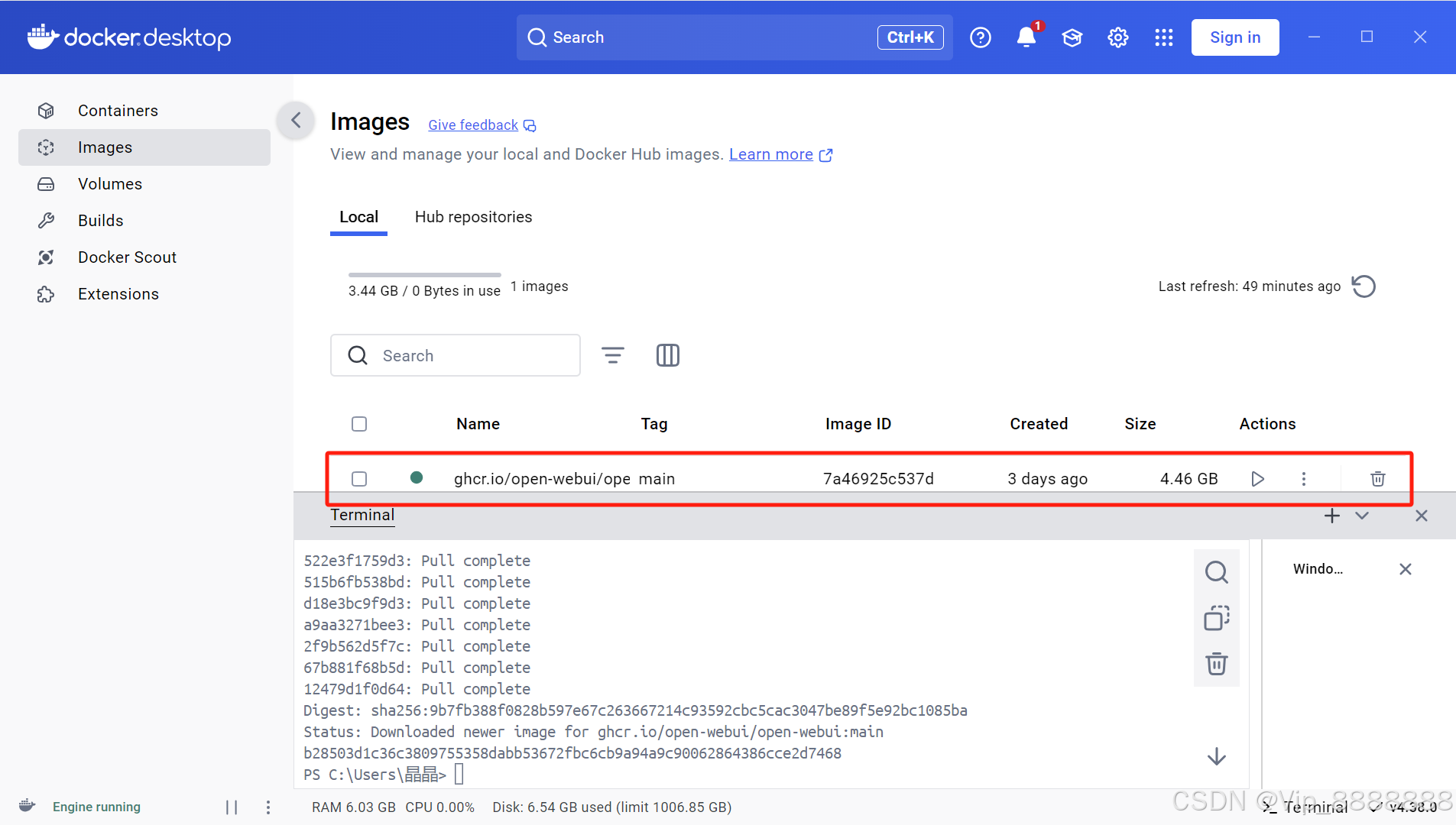

(2)安装完成之后,我们在左侧点击Images(镜像),点击运行,如果需要有配置,默认即可。

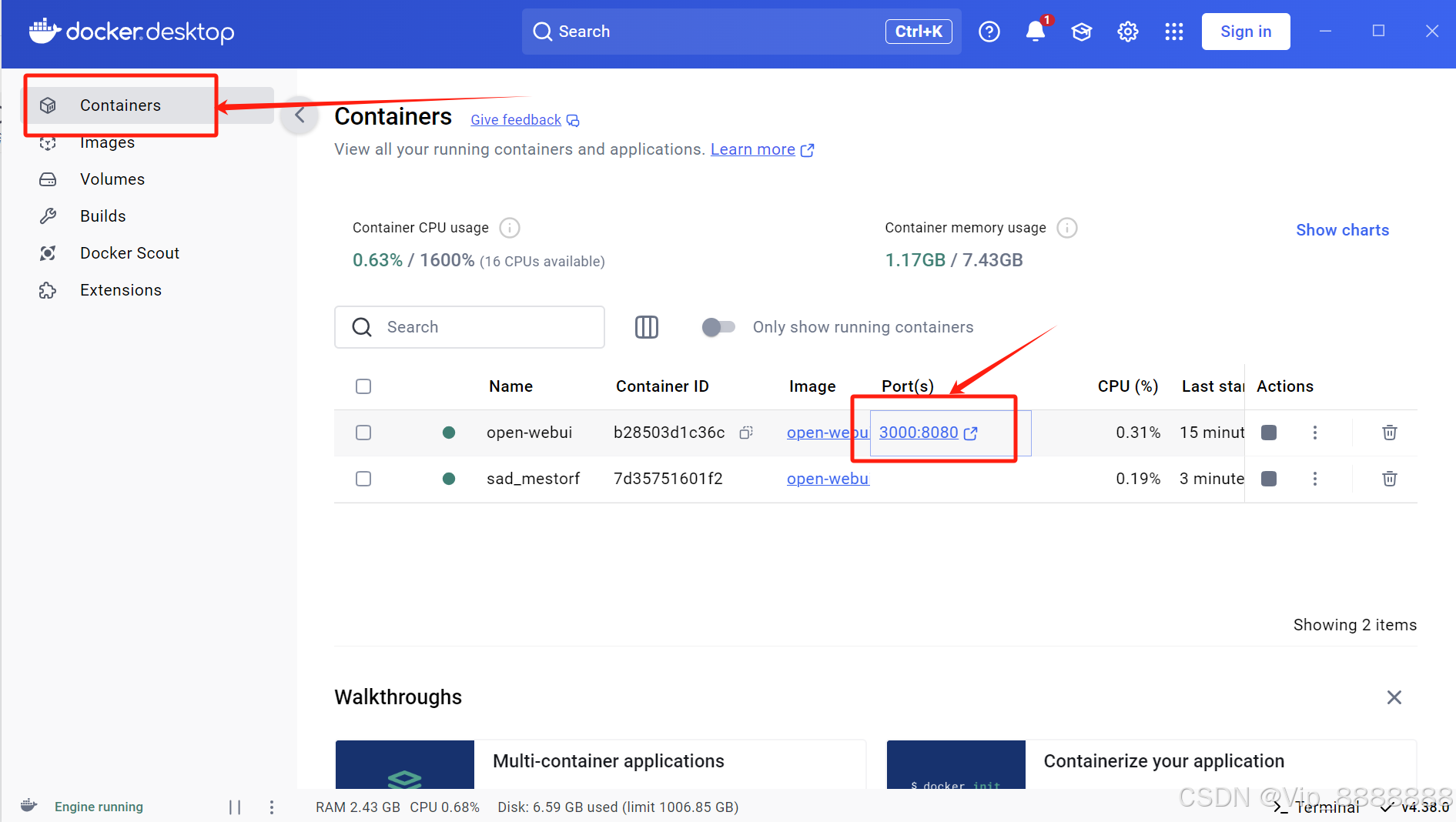

(3)点击Container(容器),点击端口号

出现以下界面,即成功!

2.4 OpenWebUI配置

Open WebUI是一个可扩展、功能丰富、用户友好的自托管 WebUI,旨在完全离线操作。它支持各种LLM运行程序,包括 Ollama 和 OpenAI 兼容的 API。Open WebUI 适配了 Ollama 接口,提供了 web 的方式来访问 Ollama API。

2.4.1 启动 open-webui

点击【开始使用】

创建管理员账号:

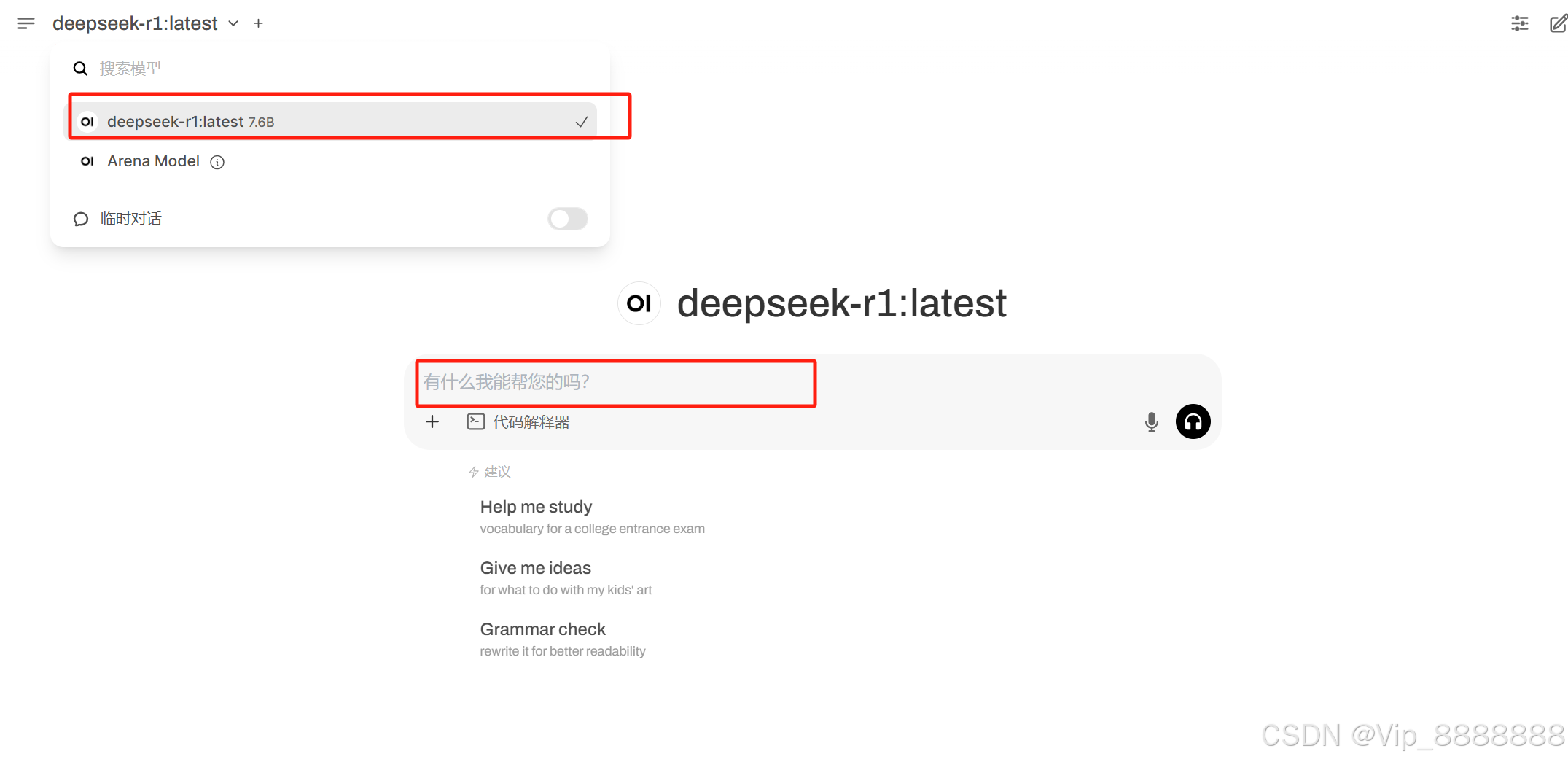

即可开始使用!

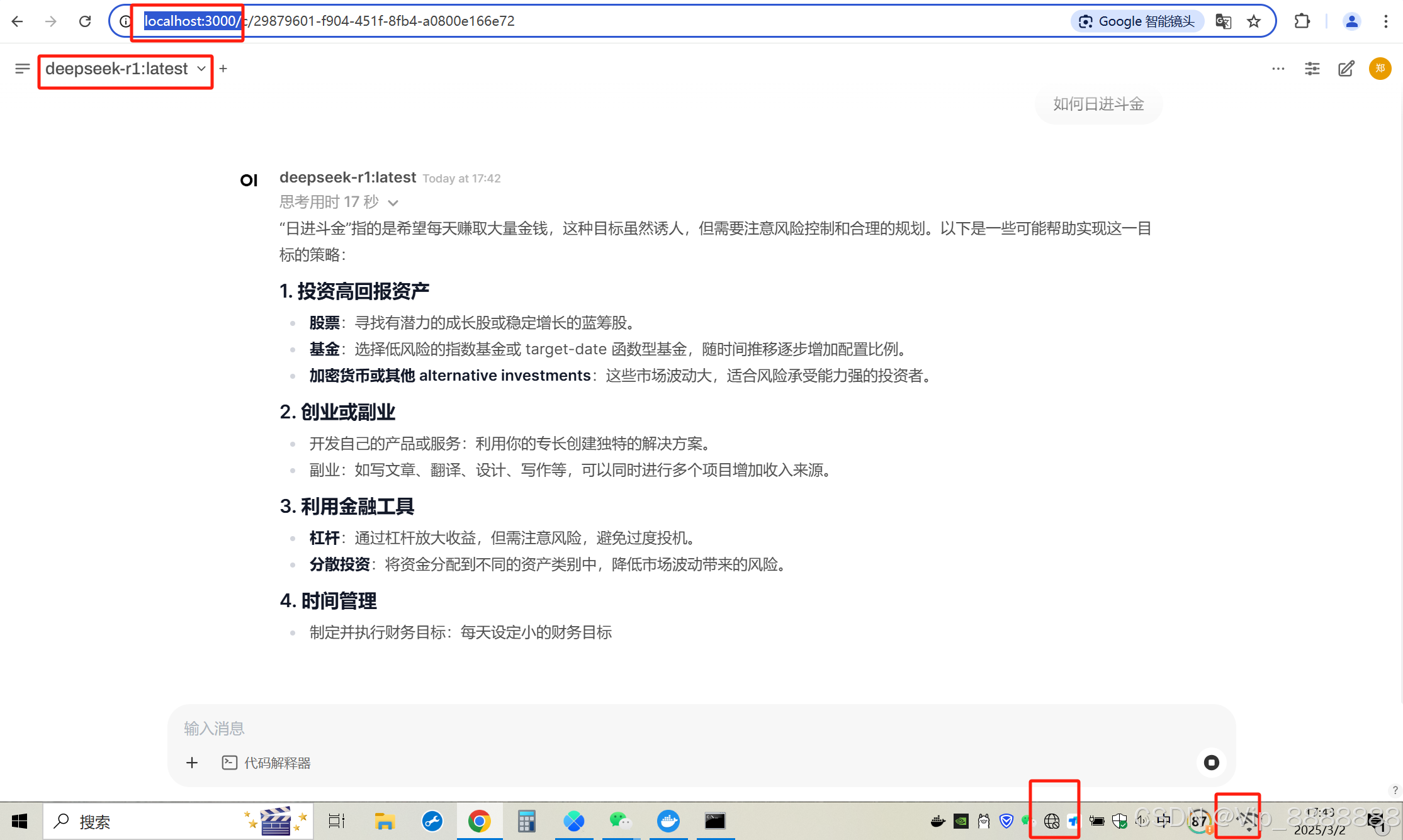

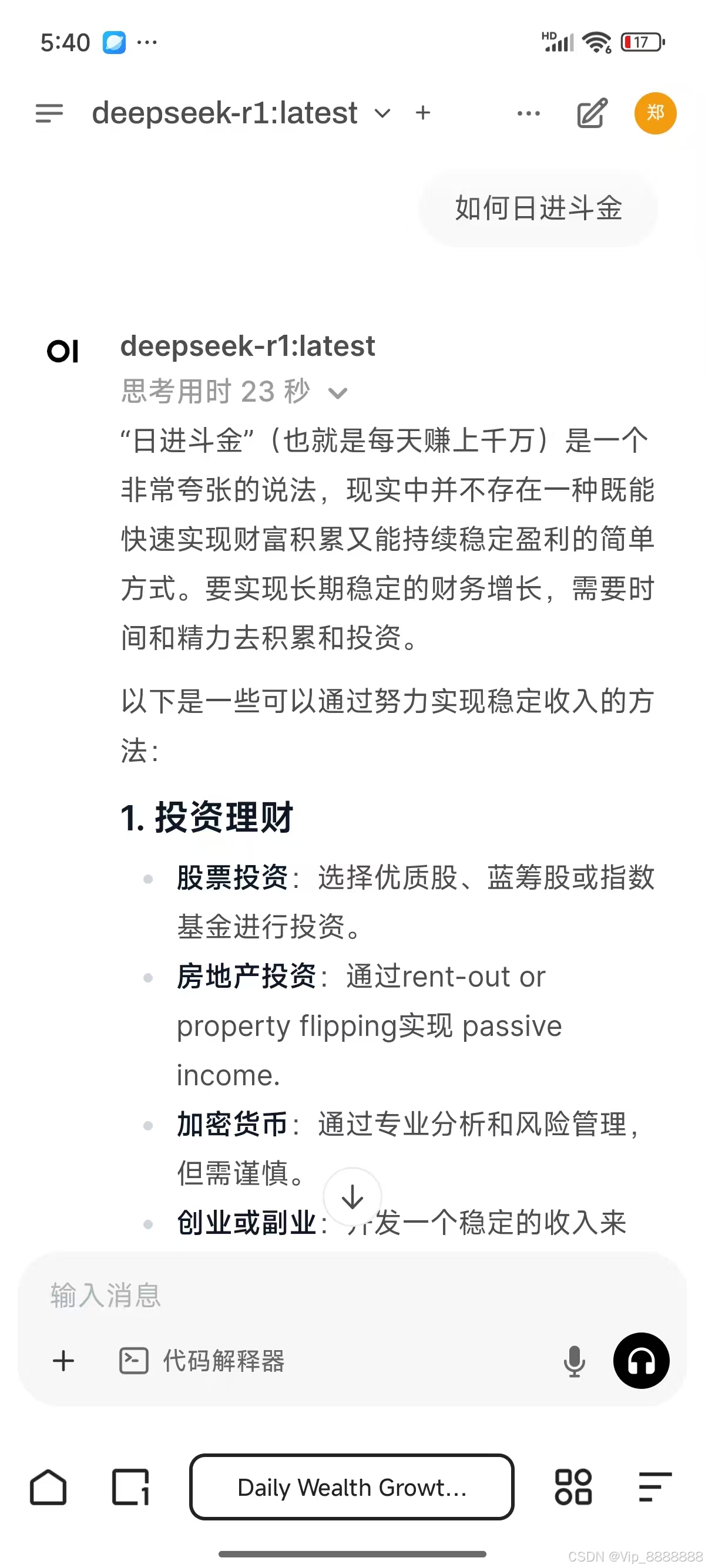

2.4.2 功能测试:正常!

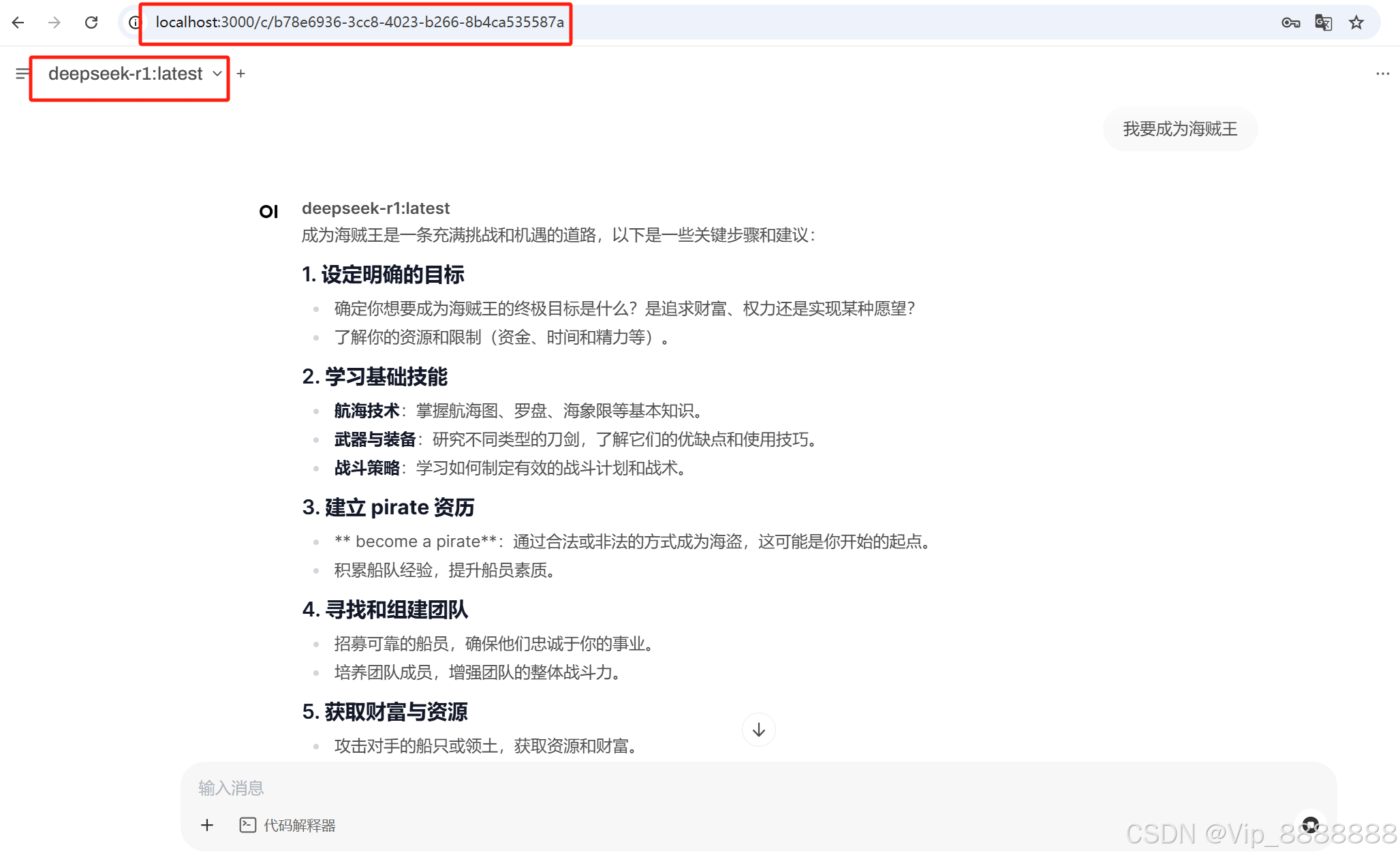

(1)本地测试:功能正常

(2)无互联网情景下测试:功能正常

(3)局域网内其他终端测试:功能正常!(安卓手机)

第三章、总结即下期规划

3.1 本次学习测试总结:

- Deepseek支持私有化部署且在无互联网的情景下完成思考任务。

- Deepseek运行对配置要求很高,本次测试思考时间较长

3.2 下期规划:

即将开启:《玩转 Deepseek——第2篇、知识库部署及使用》 时间:2025年3月29日