【Deepseek实战系列】docker+dify+ollama+deepseek本地化部署

开年来Deepseek热度飙升。

博主计划出一期关于Deepseek的专题文章,以实际操作的第一视角来讲解docker+dify+ollama+deepseek系列应用。一是在本地的电脑或服务器上部署自己的大模型和知识库。二是将AI对自然语言理解、推理能力和知识库的标准化的能力接入到我们自己应用系统。

喜欢动手的小伙伴们欢迎点赞关注,如有疑问欢迎在评论区留言或联系博主。

第一步:部署基础环境

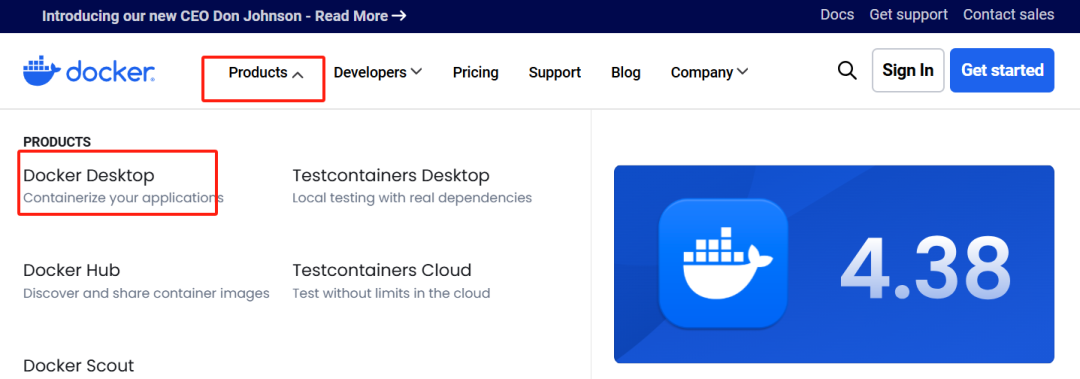

访问Docker官方网站 https://www.docker.com/

进入软件下载界面。

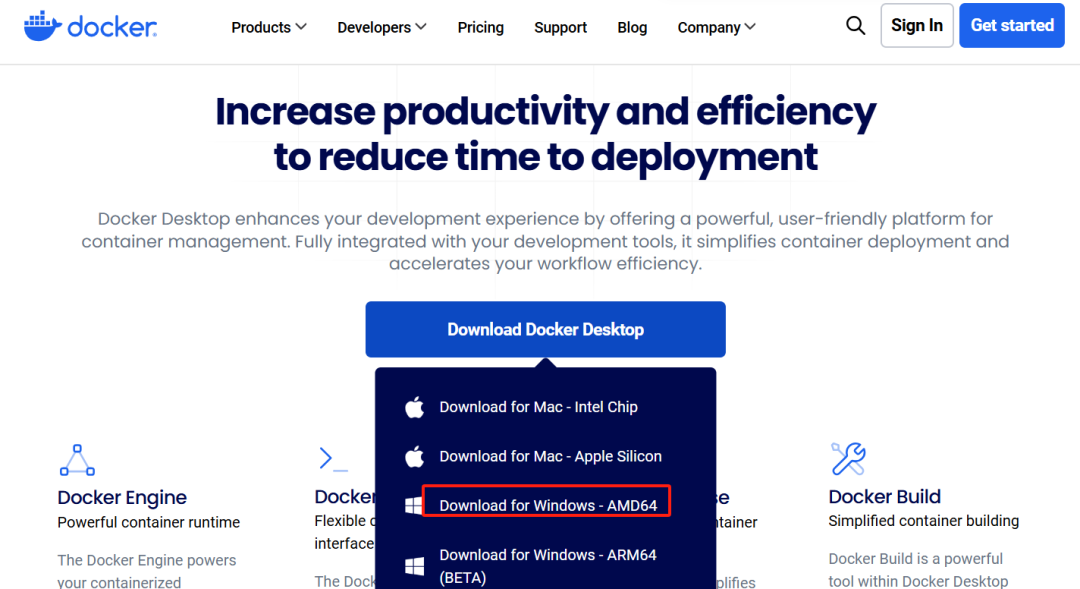

根据自己电脑操作系统选择下载安装包,我电脑是windows系统,因此下载Windows的(Docker Desktop 是 Docker 在 Windows 10 操作系统上的官方安装方式,这个方法依然属于先在虚拟机中安装 Linux 然后再安装 Docker 的方法)。

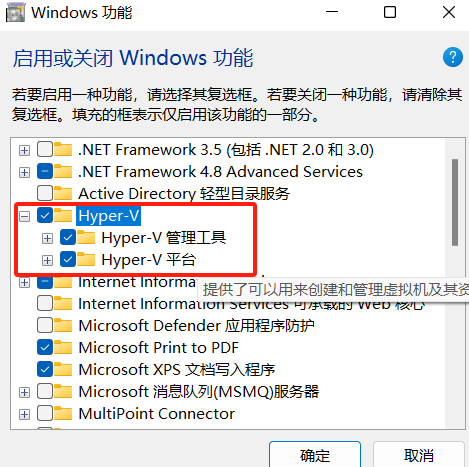

安装 Hyper-V

Hyper-V 是微软开发的虚拟机,类似于 VMWare 或 VirtualBox,仅适用于 Windows 10。这是 Docker Desktop for Windows 所使用的虚拟机。

这个虚拟机一旦启用,QEMU、VirtualBox 或 VMWare Workstation 15 及以下版本将无法使用!如果你必须在电脑上使用其他虚拟机(例如开发 Android 应用必须使用的模拟器),请不要使用 Hyper-V。

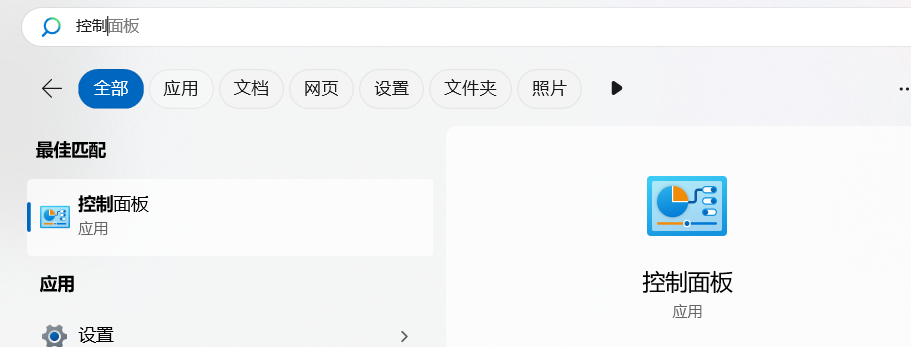

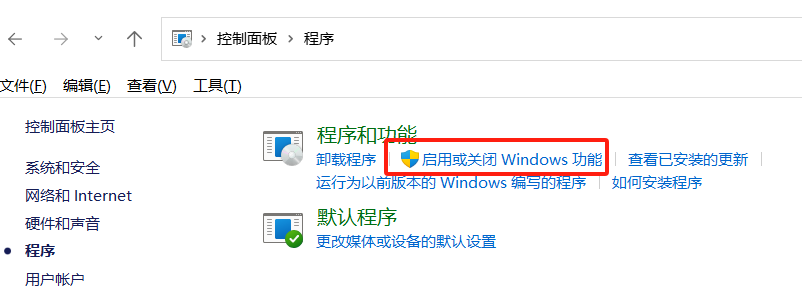

开启 Hyper-V,进入系统控制面板>程序>启用或关闭Windows功

能。

选中Hyper-V,启用。

也可以通过命令来启用 Hyper-V ,请右键开始菜单并以管理员身份运行 PowerShell,执行以下命令:

Enable-WindowsOptionalFeature -Online -FeatureName Microsoft-Hyper-V -All

安装 Docker Desktop for Windows。

运行下载的安装包,一路 Next,点击 Finish 完成安装。

安装完成后,Docker 会自动启动。通知栏上会出现个小鲸鱼的图标,这表示 Docker 正在运行。

如果启动中遇到因 WSL 2 导致错误,请安装 WSL 2。

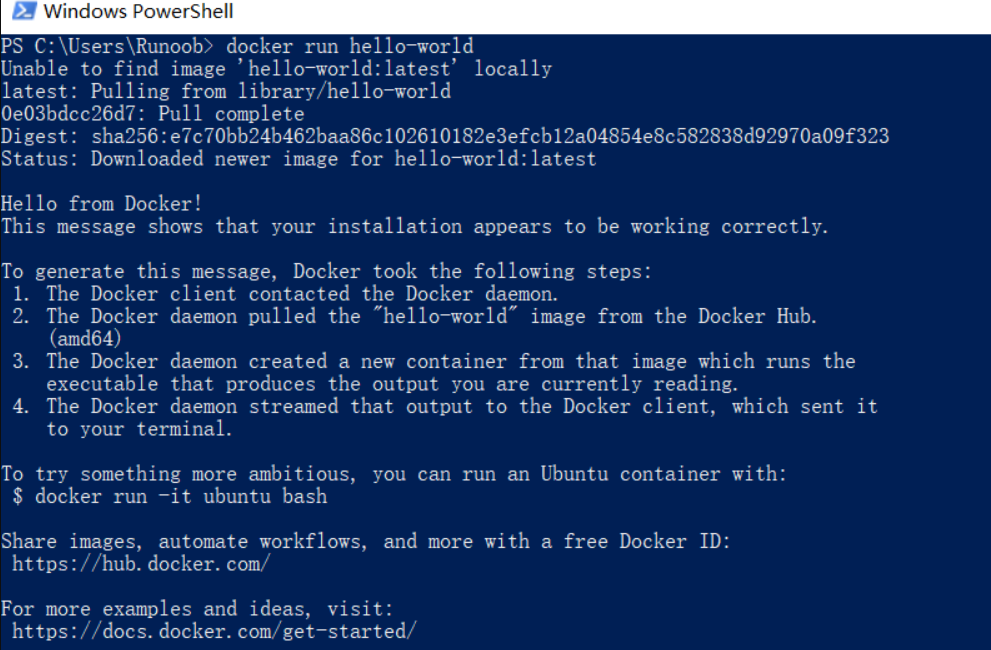

安装之后,可以打开 PowerShell 并运行以下命令检测是否运行成功:

docker run hello-world

在成功运行之后应该会出现以下信息:

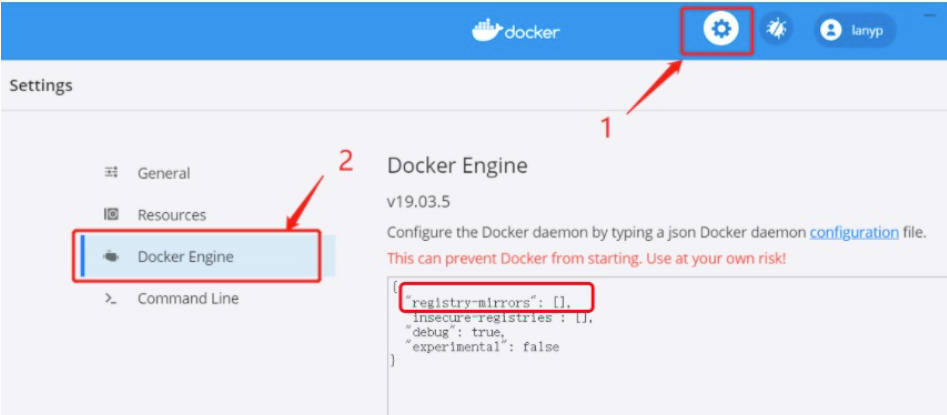

Docker 镜像加速。

国内从 DockerHub 拉取镜像有时会遇到困难,此时可以配置镜像加速器。

目前国内 Docker 镜像源出现了一些问题,基本不能用了,后期能用我再更新下。

对于使用 Windows 10 的系统,在系统右下角托盘 Docker 图标内右键菜单选择 Settings,打开配置窗口后左侧导航菜单选择 Daemon。在 Registrymirrors 一栏中填写加速器地址 https://docker.mirrors.ustc.edu.cn/ ,之后点击 Apply 保存后 Docker 就会重启并应用配置的镜像地址了。

第二步: 安装dify

登录网址 https://github.com/langgenius/dify,点击Dnowload ZIP。下载到本地并解压。注意: 在本地的保存路径尽量不要有中文字符。

windows进入powershell(不是CMD)。进入dify解压包下面的docker目录,分别执行下面两条命令

cp .env.example .env

docker -compose up -d

docker会拉取dify进行下载

大概时间20分钟左右。下载完成

重启docker 桌面软件,在containers中能看到docker的这个image,表示Dify下载成功。Status显示Running表示正在运行。

第三步: 本地化部署deepseek

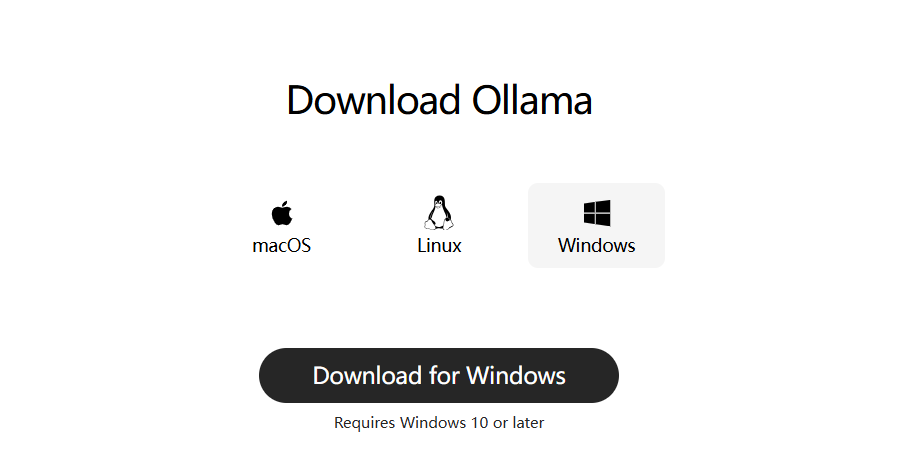

这里我们通过ollama进行DeepSeek本地部署。

登录官网:https://ollama.com/

点击Download进行下载。然后选择Windows版本,安装包有700多M。下载速度不是很稳定。下载速度慢的可以加我v,给网盘链接。

下载完后,点击安装。

注意:ollama默认安装到C盘。

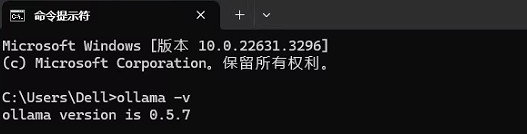

安装完成后,打开命令终端

然后运行命令

ollama -v

出现如下的界面表示ollama安装成功。

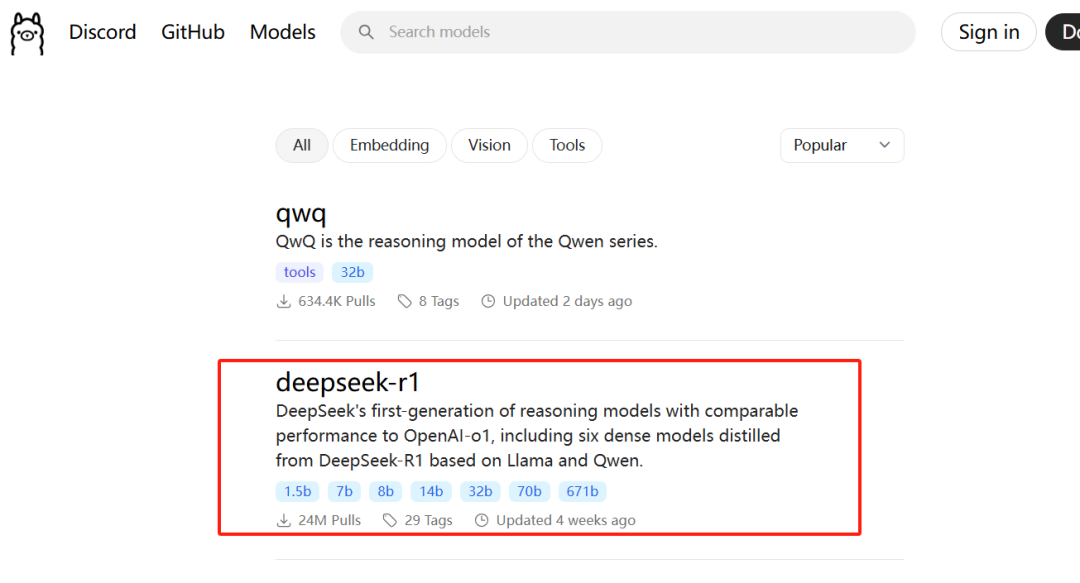

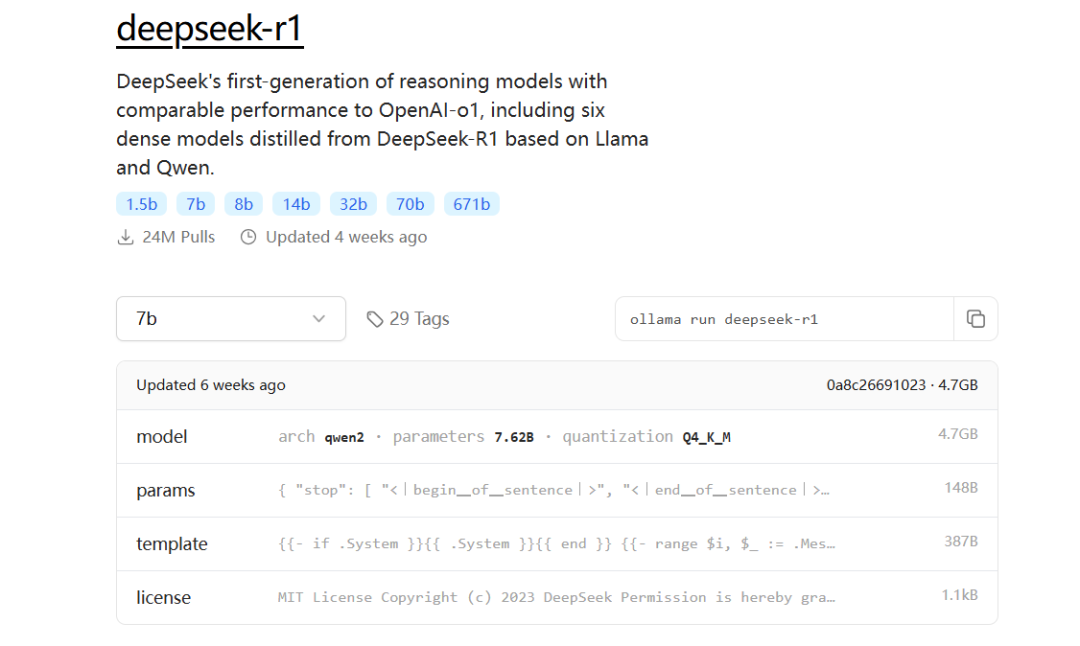

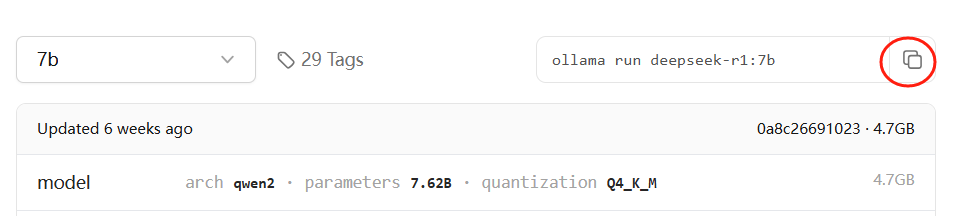

在ollama官网上选择Models,找到deepseek点击进去。

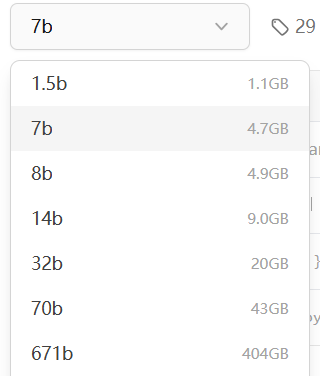

deepseek-r1有1.5b,7b,8b,14b,32b,70b,671b的选择

何评估自己电脑能跑哪个模型呢,每个版本需要的显存大小都在右边有显示

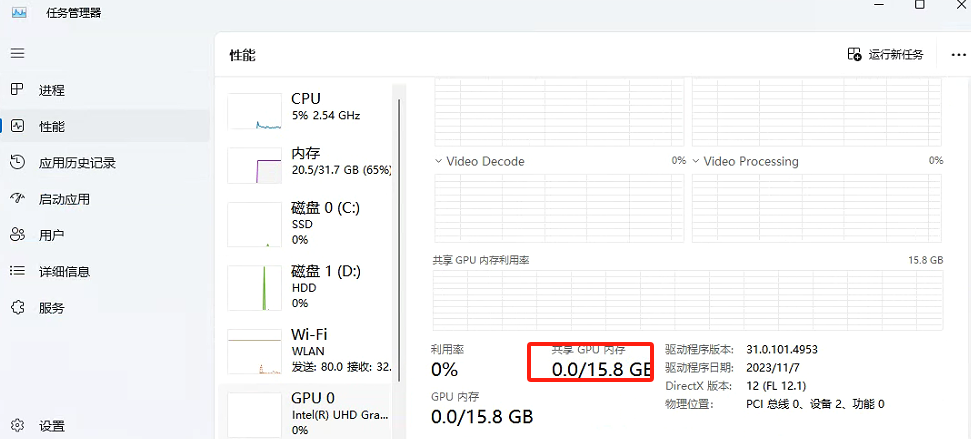

我电脑GPU内存是16GB,我选择的是14b版本。

点击按钮进行命令复制

在命令终端中运行命令

ollama run deepseek-r1:14b

等待下载安装完成,就可以本地和deepseek进行对话了

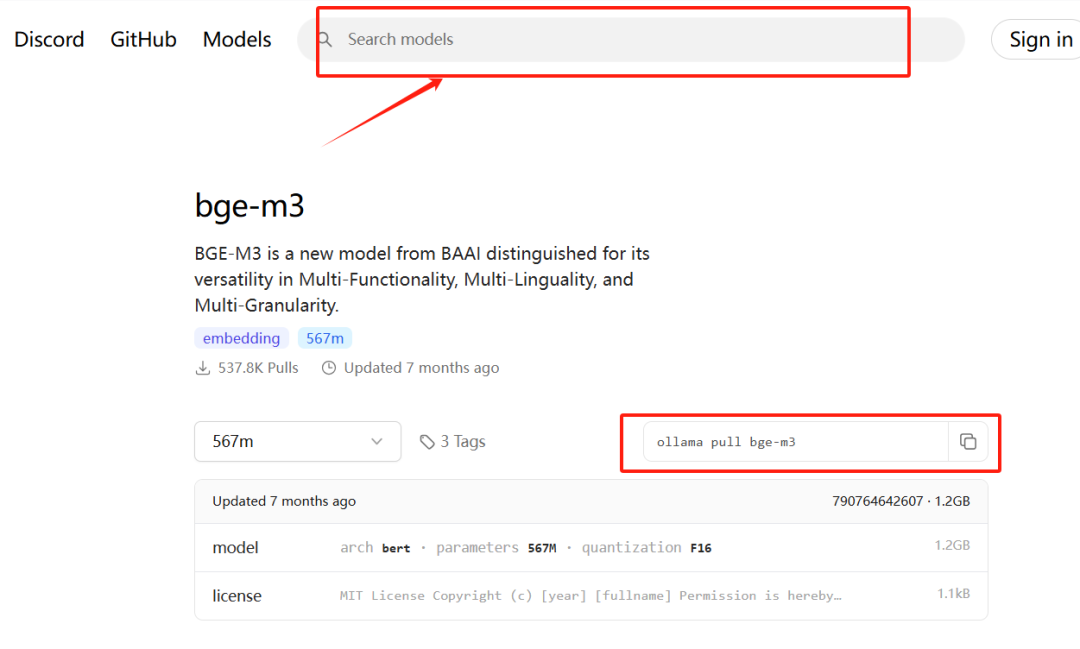

同时在ollama中搜索bge-m3。点击进入后复制命令,在命令窗口中执行复制的命令进行下载。

第三步: dify配置大模型

访问http://localhost/signin

来到dify的登录界面进行登录

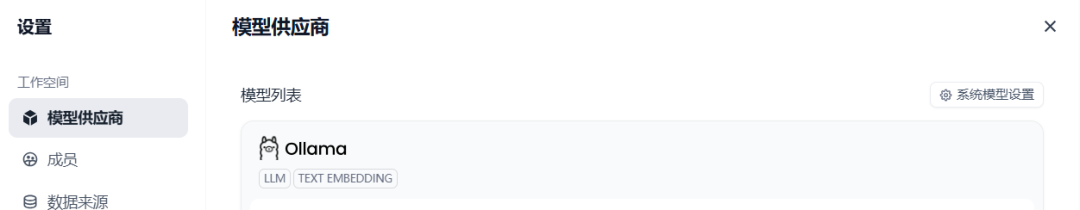

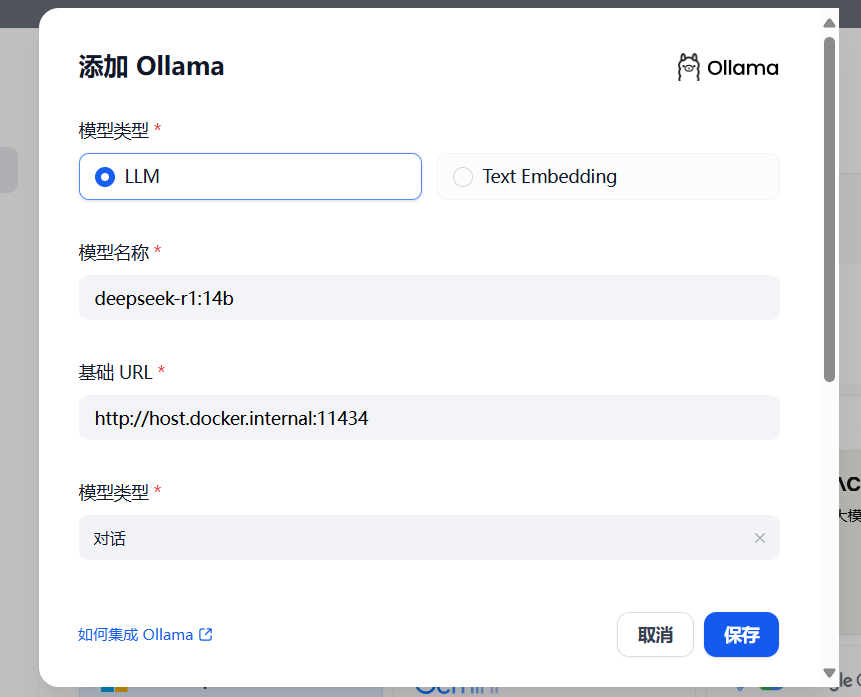

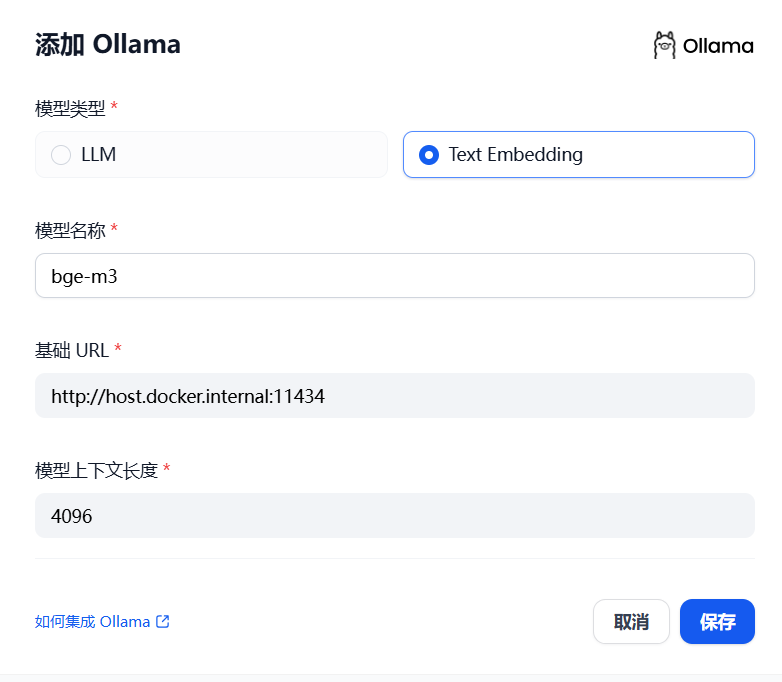

在模型供应商中找到ollama,点击添加大模型

基础URL填 http://host.docker.internal:11434(ollama部署地址),模型名称输入刚刚安装的“deepseek-r1:14b”,其他的都不变,点击保存。

基础URL填 http://host.docker.internal:11434(ollama部署地址),模型名称输入刚刚安装的“bge-m3”,其他的都不变,点击保存。

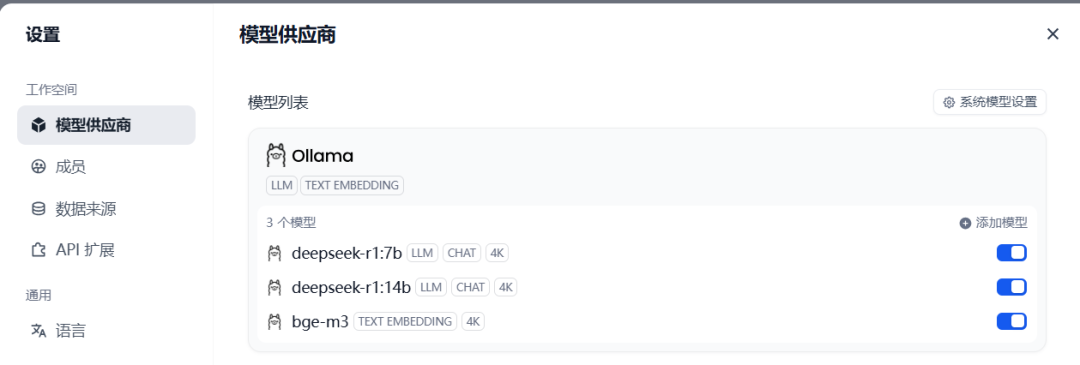

这里可以看到我已经添加的两个模型了。

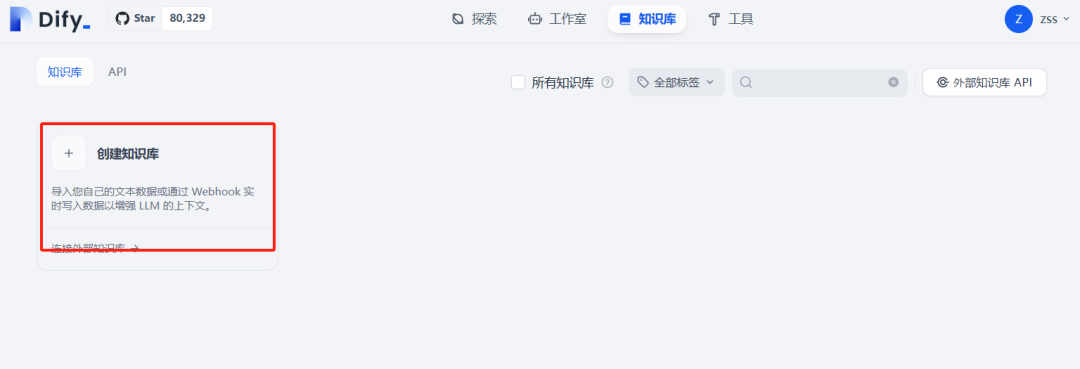

第四步: 搭建知识库

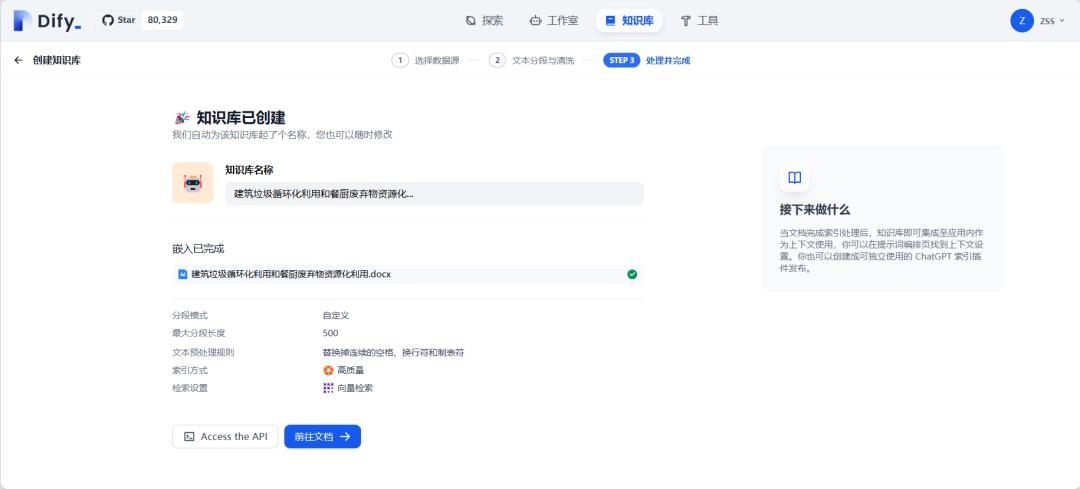

进入Dify的主界面,点击知识库。创建新的知识库,上传文档,点击下一步。

知识库的配置可以采用默认的,预览块可以右侧查看文本分段清洗情况,拖到最下面点击保存并处理。

会进行知识库的创建,显示“嵌入已完成”,代表知识库导入创建完成。

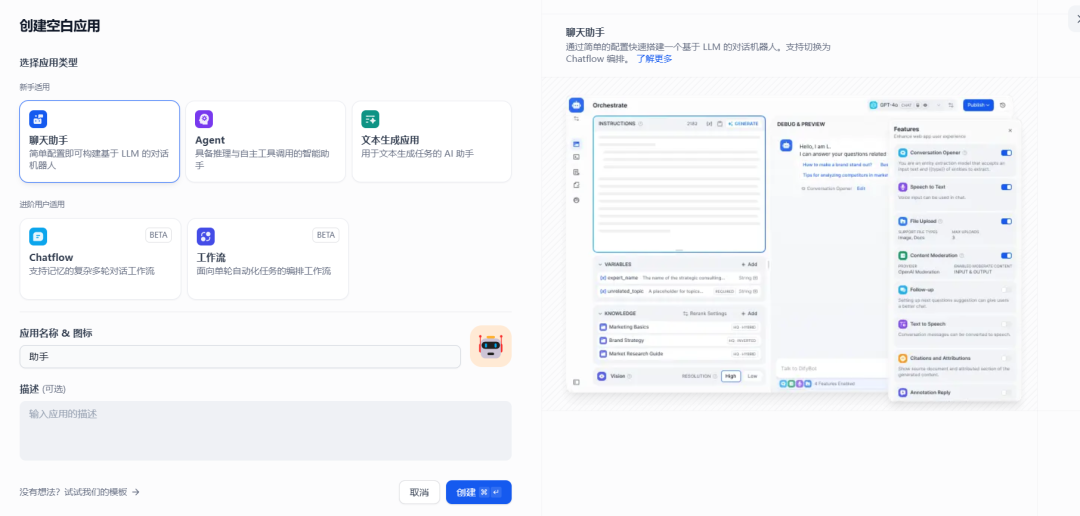

第五步: 应用创建

在工作室中创建空白应用

在聊天界面中点击添加上下文,也就是你创建的知识库。

在右边的对话框中输入,大模型会根据知识库进行查询。在最后的界面中能看到引用自刚才创建的知识库文件。

调试差不多了,点击右上角发布。

点击运行。

完成。

----------

开年现象级AI应用Deepseek引发技术圈震动!为帮助开发者掌握前沿AI部署能力,笔者将推出深度实战专栏《Docker+Dify+Ollama+Deepseek全栈应用指南》,带您亲历三大核心技术突破:

🚀 核心模块一:私有化智能中枢搭建

-

基于Docker容器化部署,实现大模型+知识库的本地安全运行

-

详解Ollama框架集成策略,构建企业级AI推理引擎

-

开源部署避坑指南:从环境配置到效能调优全解析

💡 核心模块二:智能能力标准化输出

-

自然语言理解(NLU)接口封装实战

-

多模态知识库对接企业系统的5种范式

-

自动化推理能力迁移方案(附SpringBoot/Django案例)

本系列独创"开发日志"式教学,完整重现笔者在部署过程中:

✔️ 遇到的17个典型报错及解决方案

✔️ 性能优化对比测试数据表

✔️ 企业级安全加固checklist

适合人群:全栈开发者/AI产品经理/技术负责人

技术栈全景:Docker→Ollama→Dify→Deepseek→RestfulAPI

现在关注微信公众号“地知通”,即可获取:

👉 专栏首发推送提醒

👉 配套部署脚本

👉 1v1技术咨询通道

您在本地化部署AI过程中遇到哪些挑战?欢迎在评论区留下您的问题或应用场景,笔者将选取典型问题在专栏中专项解答!让我们共同探索企业级AI落地最后一公里⛽️

敬请关注我们的公众号,更多精彩内容等你来发现!

声明:转载此文不为商业用途。文字和图片版权归原作者所有,若有来源标注错误或侵犯了您的合法权益,请与我们联系,我们将及时处理,谢谢。

DeepSeek时代,如何成为驾驭算法的“数字地理学家”

2024年全国建筑轮廓矢量数据下载

全国poi/路网/建筑/水系..(附下载地址)

如何快速下载poi兴趣点数据(附下载工具)

0.5m卫星影像(Esri影像、天地图、星图)、DEM

注册测绘师资格考试备考建议 | 附30GB学习资料

AutoCAD如何加载在线/离线遥感影像地图