Ubuntu部署deepseek(离线版)

由于实验室的服务器无法连外网,只能离线手动安装了!!!

离线下载ollama-linux-amd64.tgz

网址:https://ollama.com/download/ollama-linux-amd64.tgz

第一步:解压安装包

-

切换到目标文件夹

cd /home/zhangh/Ollama -

解压安装包

tar -xzf ollama-linux-amd64.tgz -C /usr/local这里将 Ollama 解压到

/usr/local目录下,这是一个常见的安装目录。

第二步:创建专用用户和组

-

创建专用用户和组

sudo useradd -r -s /bin/false -U -m -d /usr/local/share/ollama ollama这里创建了一个名为

ollama的专用用户和组,用户的家目录设置为/usr/local/share/ollama。 -

将你的用户添加到

ollama组sudo usermod -a -G ollama zhangh这样,你(

zhangh用户)就可以访问 Ollama 的资源了。

第三步:创建 systemd 服务文件

-

创建 systemd 服务文件 创建一个 systemd 服务文件

/etc/systemd/system/ollama.service: -

sudo vim

/etc/systemd/system/ollama.service[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=$PATH" [Install] WantedBy=default.target注意:这里假设 Ollama 的可执行文件路径为

/usr/local/bin/ollama,这是解压后的默认路径。 -

启动服务

sudo systemctl daemon-reload sudo systemctl enable ollama sudo systemctl start ollama -

验证服务状态

sudo systemctl status ollama

第四步:验证 Ollama 是否仅对你可用

-

验证 Ollama 版本 作为

zhangh用户,运行以下命令验证 Ollama 是否正常启动:ollama -v -

设置模型目录权限 确保 Ollama 的模型目录(通常是

/usr/local/share/ollama/models)的权限仅对ollama用户和组可访问:sudo mkdir /usr/local/share/ollama/models sudo chown -R ollama:ollama /usr/local/share/ollama/models sudo chmod -R 700 /usr/local/share/ollama/models

第五步:下载模型相关文件并且利用ollama部署模型

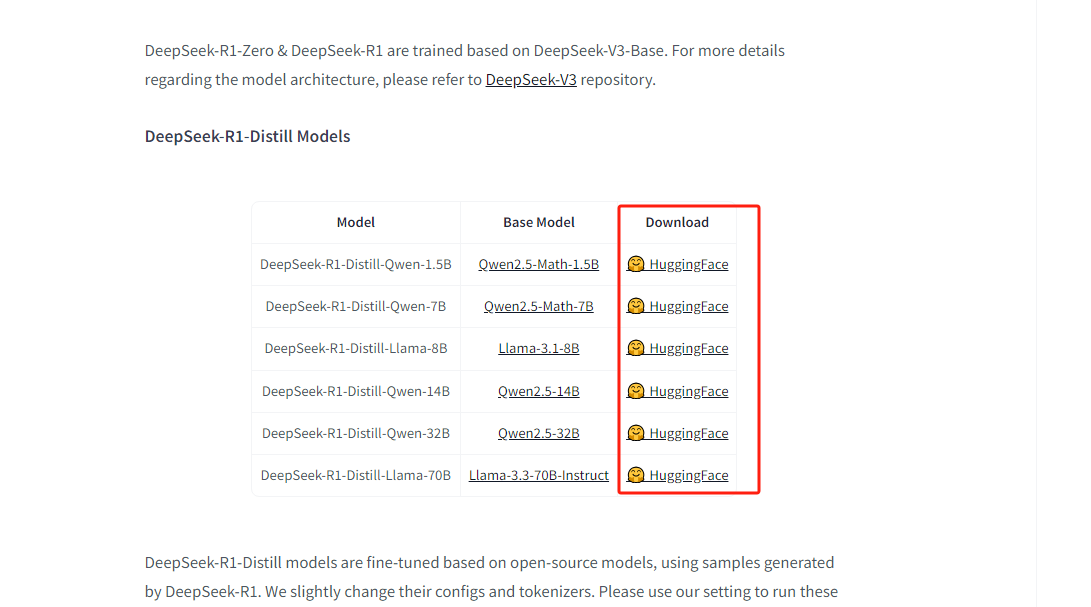

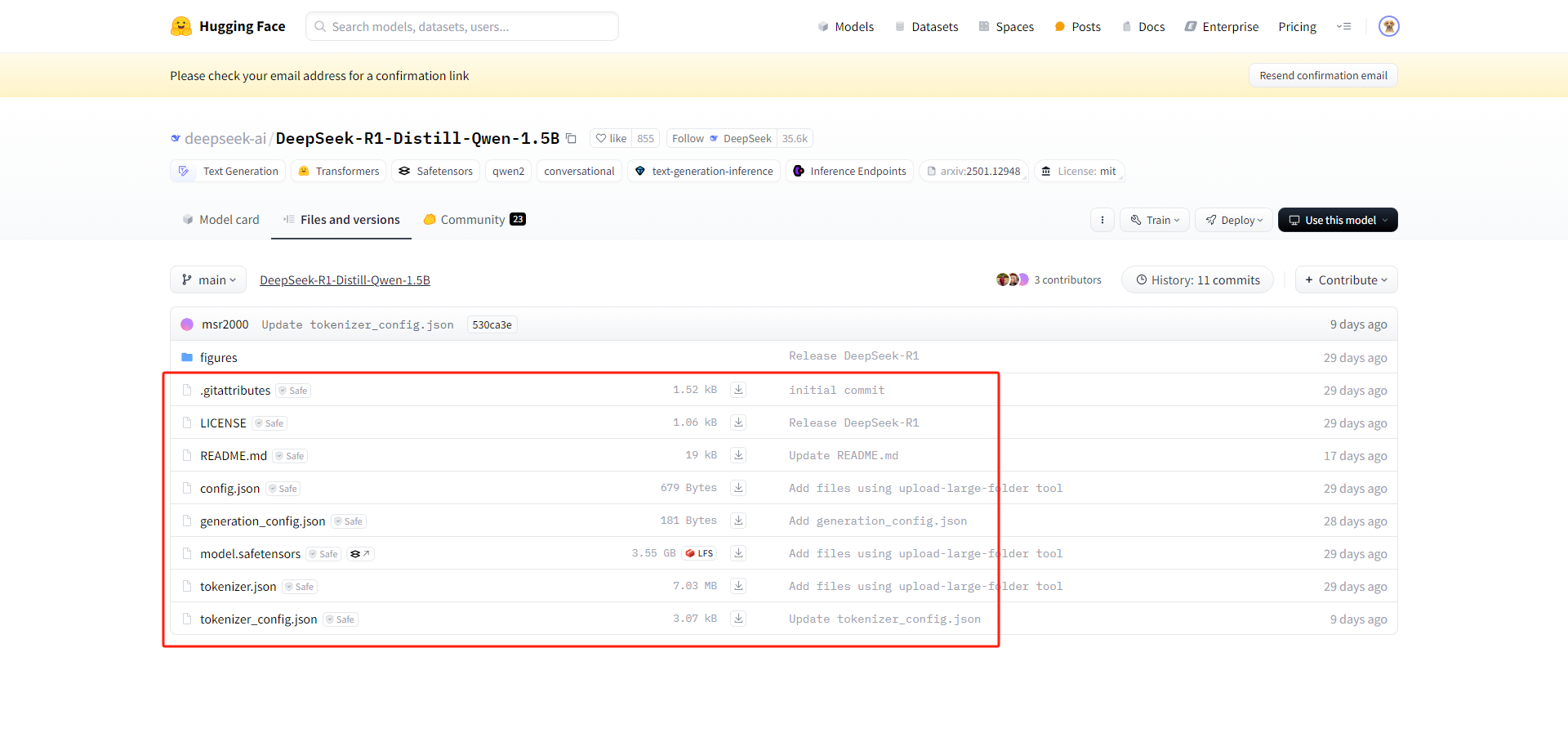

5.1 下载deepseek模型

下载模型链接:https://huggingface.co/deepseek-ai/DeepSeek-R1,把

到文件夹(随便创建)

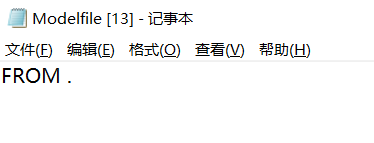

5.2 配置Modelfile

在创建的模型文件夹创建一个Modelfile,添加以下内容即可

FROM .

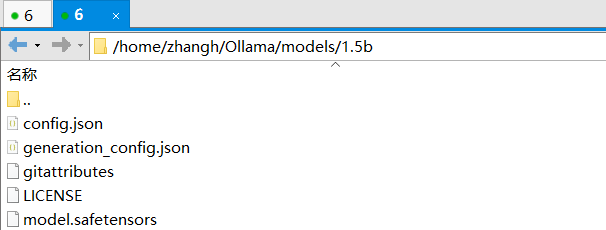

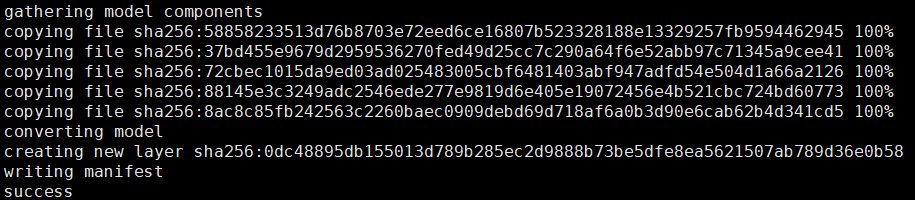

5.3 本地导入模型

终端运行:

ollama create deepseek-r1-1.5b -f /home/zhangh/Ollama/models/1.5b/Modelfile

输出:

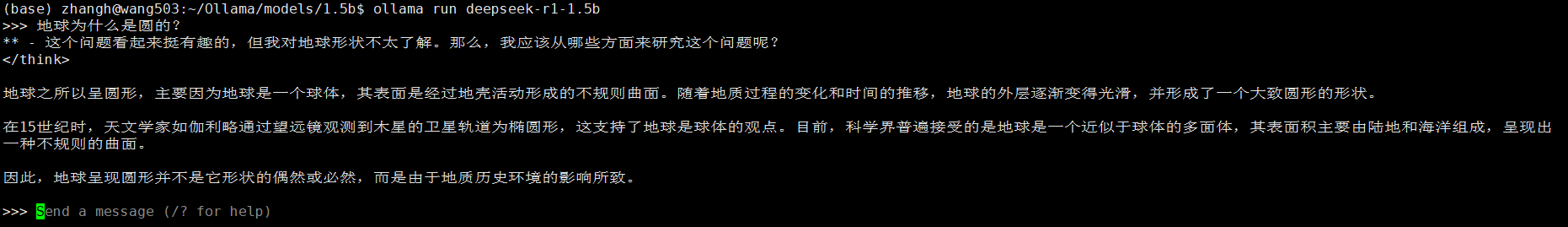

5.4 运行模型

ollama run deepseek-r1-1.5b

参考博客:

详细!离线部署大模型:ollama+deepseek+open-webui安装使用方法及常见问题解决 - 志文工作室