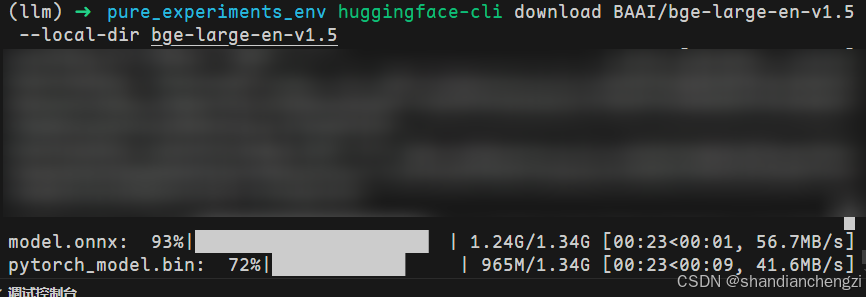

【记录】LLM|HuggingFaceEmbeddings加载本地模型(Linux)

文章目录

- 前言

- HuggingFace 模型加载方式

- 方式一 使用Langchain加载(推荐)

- 方式二 huggingface-cli下载

- HuggingFace 模型下载提速

成文验证时间:2025/04/22

若之后接口更新,本方法无法使用,请在评论区留言,我看到之后可能会更新新版。

本文适用于Linux场景,对于Windows场景请自行判断终端指令的修改方法。

若无特殊指出,本文中提到的指令都是在终端直接运行的。

前言

网上会说用HuggingFaceEmbeddings模型,但没提怎么用还没安装的本地模型。不知道是否有和我一样误入歧途HuggingFace网站内逐个去下载和安装文件的,其实不用,这里写一下最正常的本地模型加载方式。

HuggingFace 模型加载方式

方式一 使用Langchain加载(推荐)

安装依赖:

pip install langchain-huggingface

python代码直接运行:

from langchain_huggingface import HuggingFaceEmbeddings

model_name = "BAAI/bge-large-en-v1.5"

embeddings = HuggingFaceEmbeddings(

cache_folder='./hf_models',

# local_files_only=True, # 强制本地加载,这个参数已经废除了

model_name=model_name)

以上代码的模型"BAAI/bge-large-en-v1.5"可以改成你自己喜欢的模型,“‘./hf_models’”可以改成你自己喜欢的路径。

文本嵌入模型可以看Huggingface的MTEB(Massive Multilingual Text Embedding Benchmark,大规模多语言文本嵌入基准测试)排行榜,需要科学上网才能打开,链接是https://huggingface.co/spaces/mteb/leaderboard

关于这个排行榜的更多介绍可以看MTEB排行榜embedding模型实测 - 知乎这篇博客。暂时未发现该排行榜的国内镜像站。

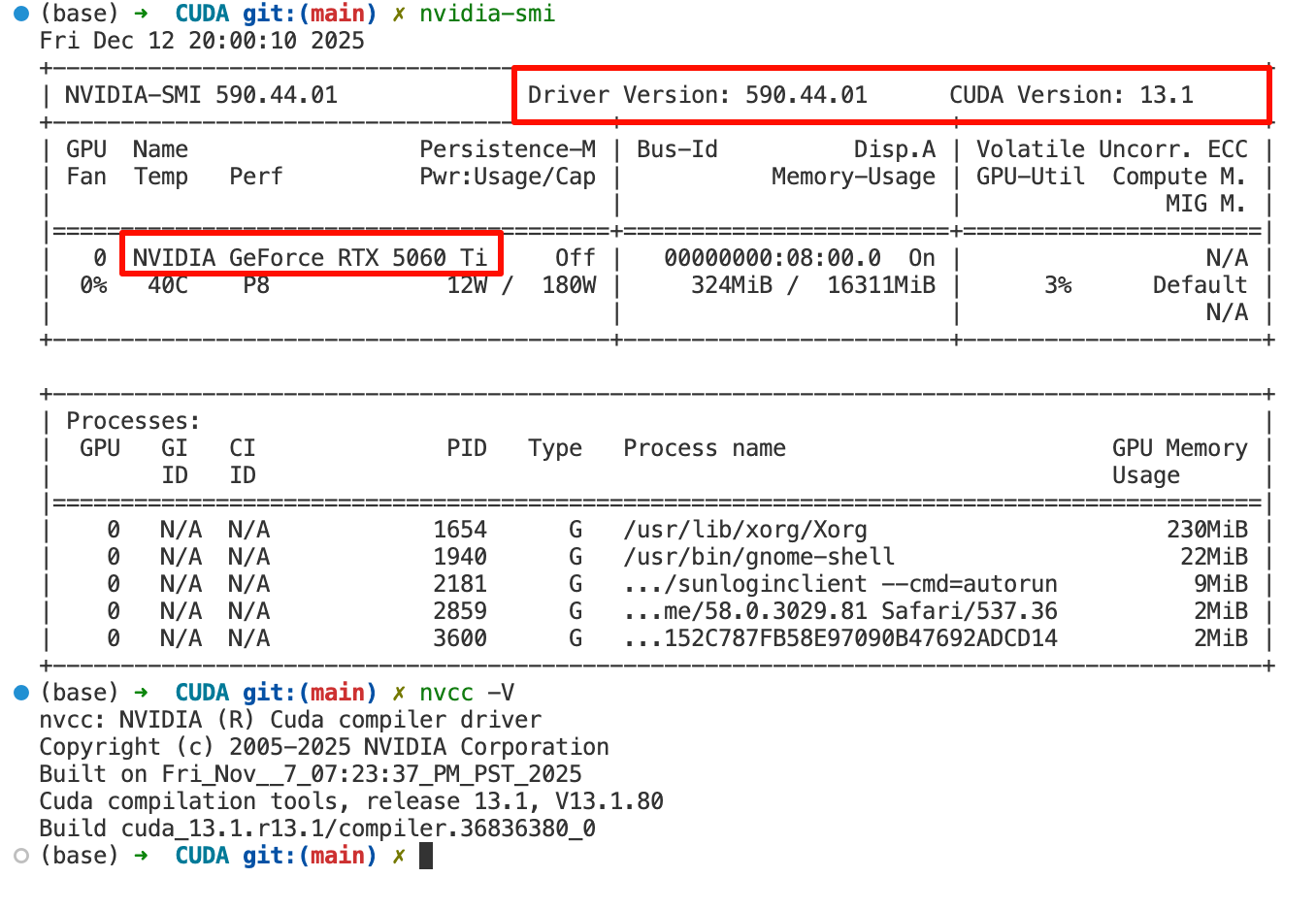

首次运行代码,就会出现这样的输出,表示下载成功:

如果你发现迟迟没有输出任何内容,要么是说明你之前就装过,要么是这仅仅说明你的网络状况不支持访问HuggingFace。此时不要慌,请往下滑,翻到“HuggingFace 模型下载提速”,本文提供了加速访问的镜像方式,只要粘贴一行指令即可正常输出结果。

方式二 huggingface-cli下载

参考:huggingface 模型下载与离线加载 - 知乎

这个方式能成功下载,但这是搭配Transformer之类的使用的,我没用使用过,请自行判断可行性。

安装依赖:

pip install -U huggingface_hub

终端运行:

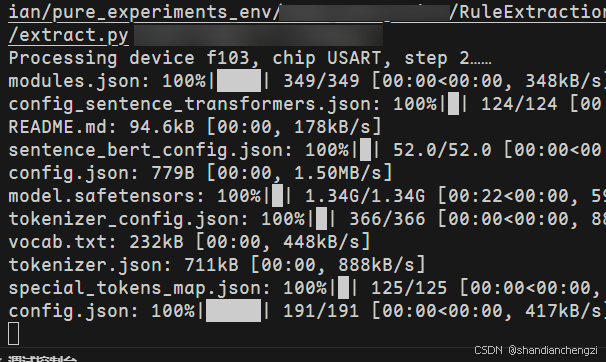

huggingface-cli download BAAI/bge-large-en-v1.5 --local-dir bge-large-en-v1.5

即可见到下载结果:

如果你发现迟迟没有输出任何内容,这仅仅说明你的网络状况不支持访问HuggingFace。此时不要慌,请往下滑,翻到“HuggingFace 模型下载提速”,本文提供了加速访问的镜像方式,只要粘贴一行指令即可正常输出结果。

HuggingFace 模型下载提速

参考:huggingface 模型下载提速 - 知乎

在终端运行(或者将这个指令写在终端的配置文件的末尾,例如~/.bashrc或~/.zshrc):

export HF_ENDPOINT=https://hf-mirror.com

现在的 HuggingFace 下载能够自动断点续传,所以不需要加参考文章中提到的其他杂七杂八的参数了。

本账号所有文章均为原创,欢迎转载,请注明文章出处:https://shandianchengzi.blog.csdn.net/article/details/147143793。百度和各类采集站皆不可信,搜索请谨慎鉴别。技术类文章一般都有时效性,本人习惯不定期对自己的博文进行修正和更新,因此请访问出处以查看本文的最新版本。

本文地址:https://www.vps345.com/13832.html