实验室服务器利用docker部署Llama3本地拉取打包上传流程

整体思路:

- docker拉取ollama/ollama 镜像运行ollama

- 进入容器使用ollama拉取运行模型 llama3

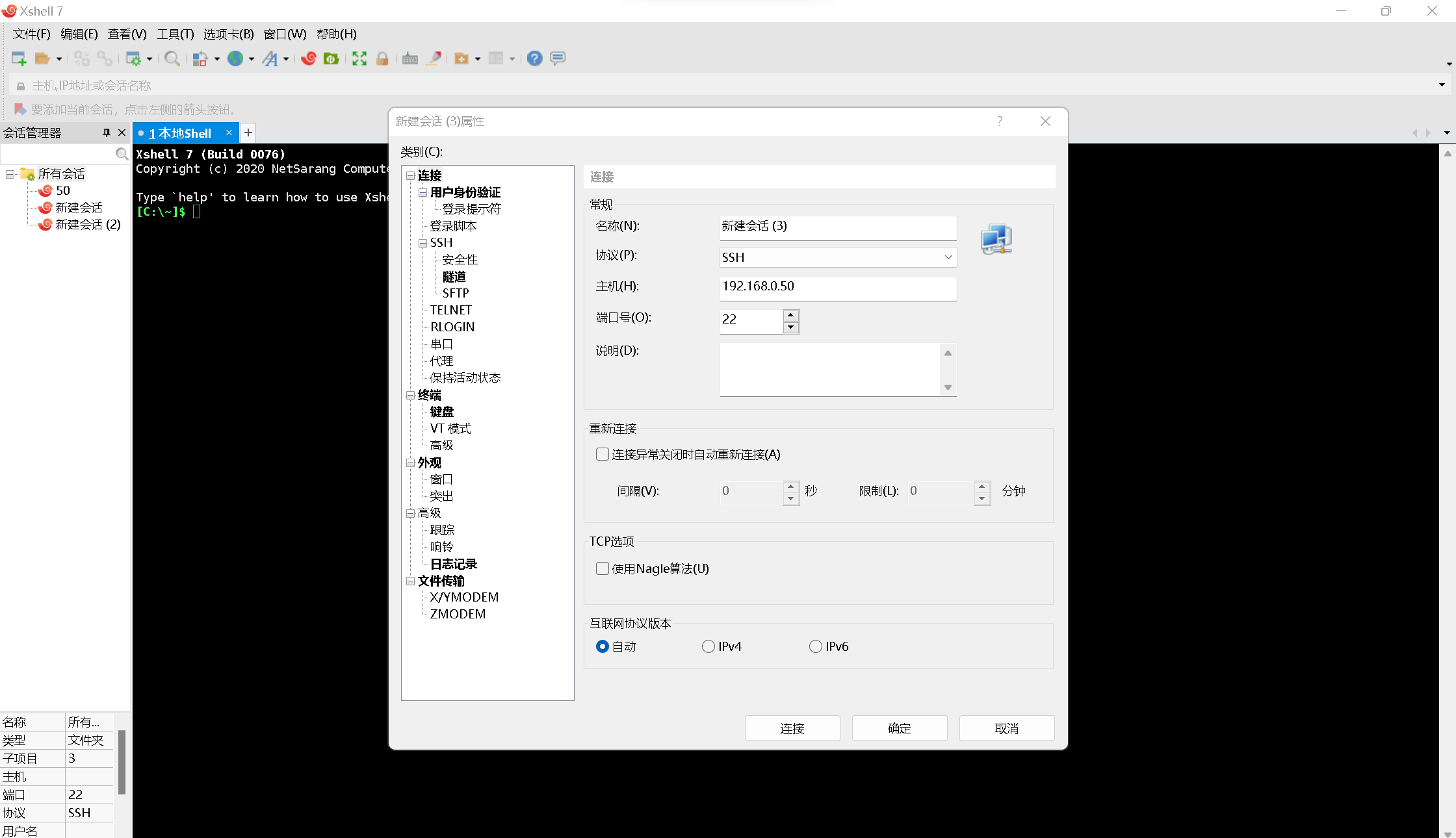

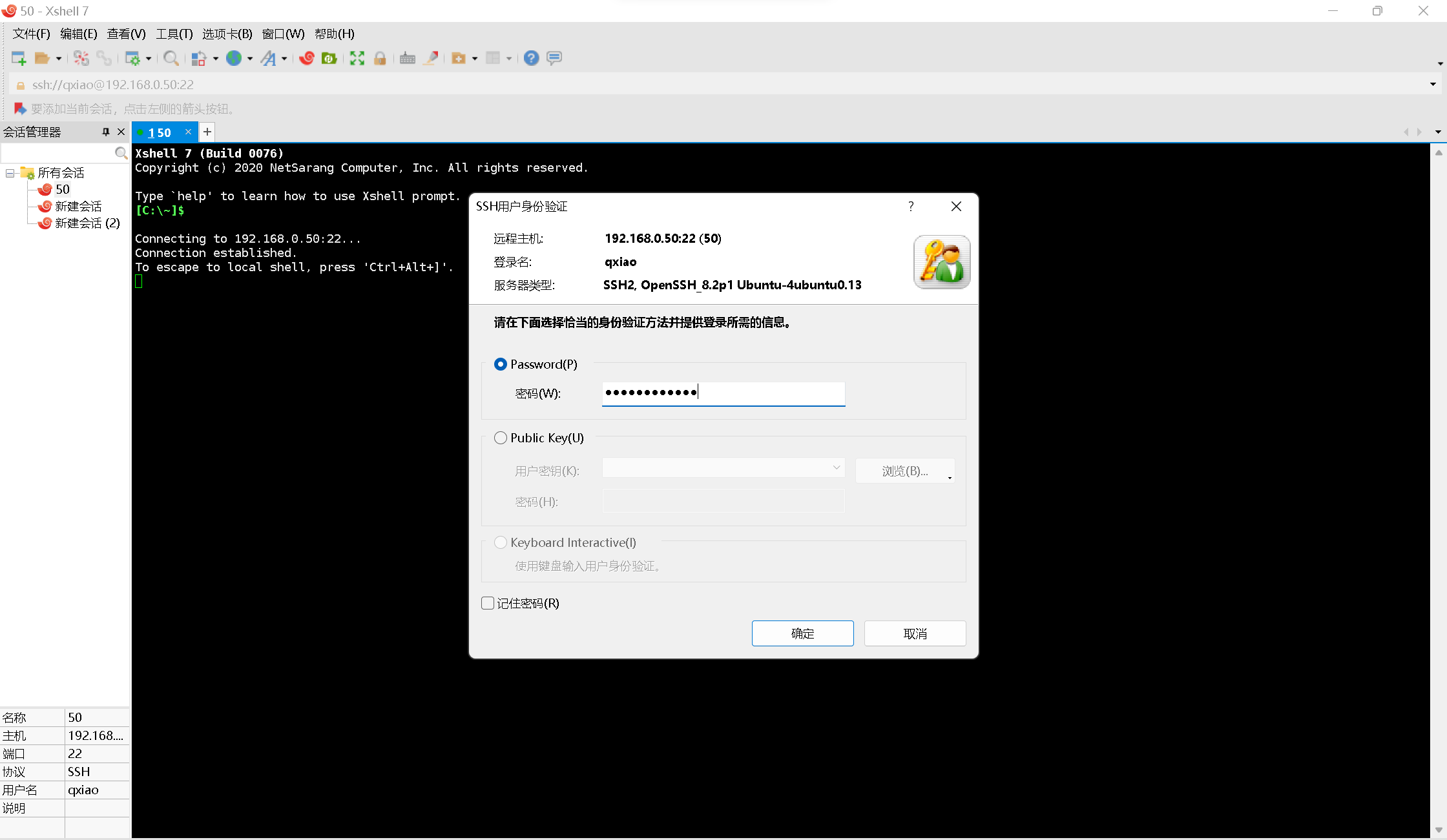

准备工作,xshell连接服务器,下面的对服务器上的操作都是在xshell上面输入指令。我这里是Linux的服务器,学校的内网下直接输ip端口号连接输入密码就可以。(xshell是B站找的免费的)

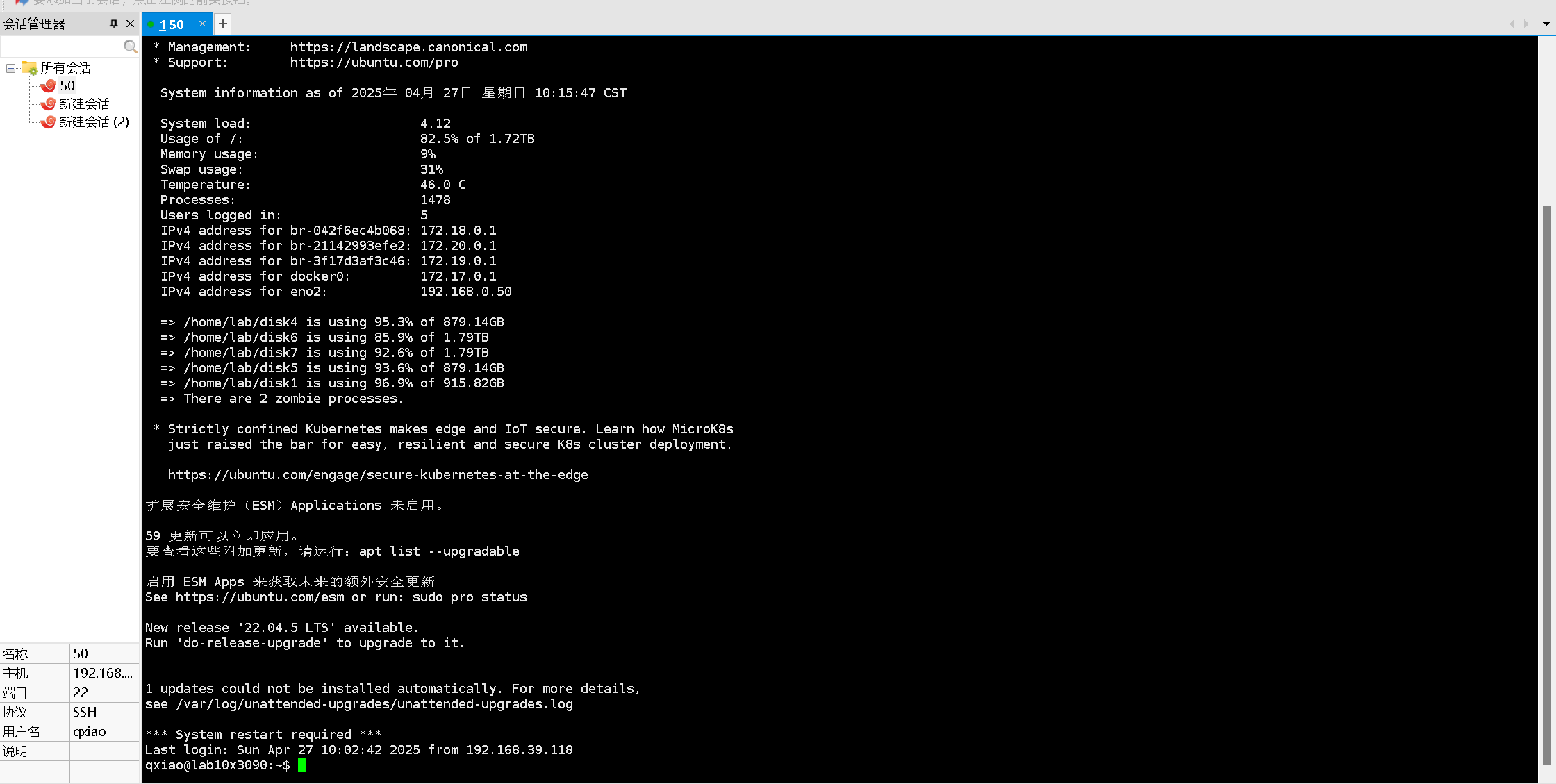

目前用的是学校的服务器,docker还有显卡是默认配置好了的。所以不用进行前面的配置操作。

如下图所示就连接成功了

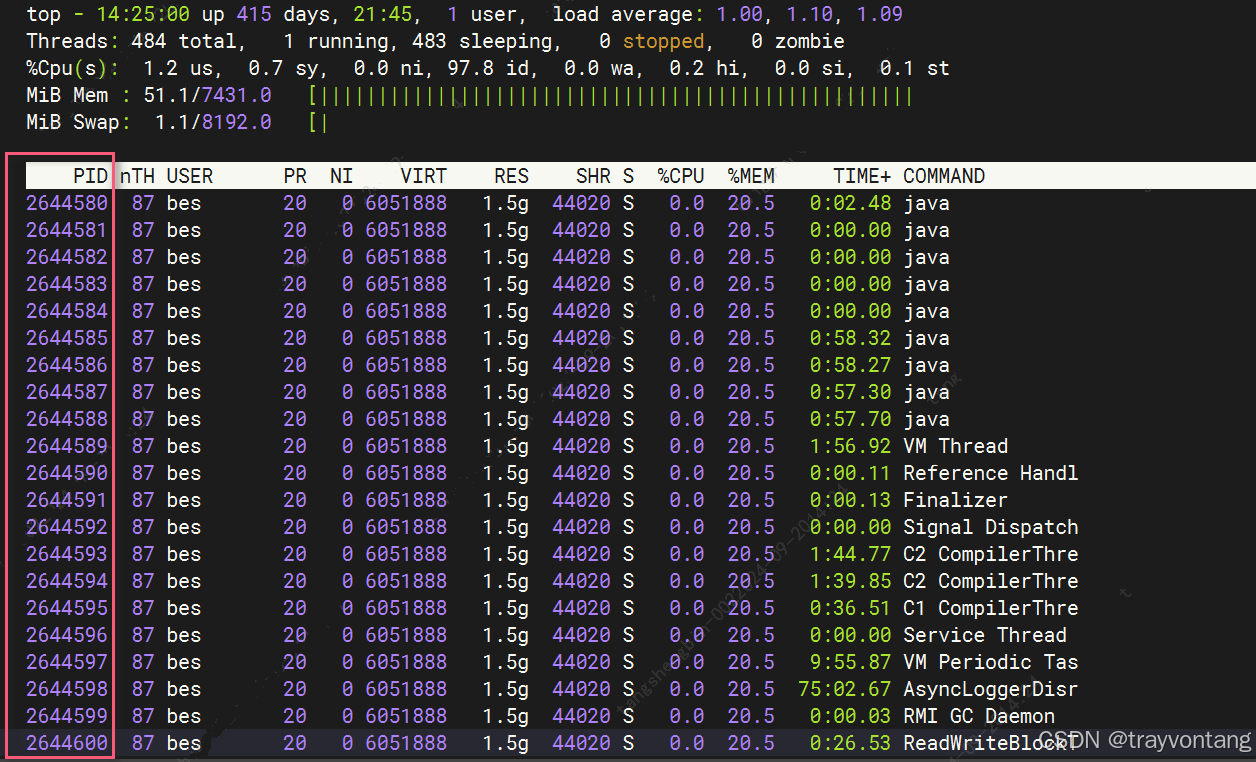

首先使用(1)docker从 Docker Hub拉取ollama/ollama 镜像运行:(一般直接拉取不行)

直接拉取会遇到网络问题,一般是国内网,在电脑上用梯子不行。

可以修改docker配置文件,添加阿里云镜像,但是没有权限修改,(ubuntu的安全策略限制了)目前找到以下本地拉取后打包传输的解决方法。

(前三步就是在自己电脑上不用服务器进行)

目录

1. 在一台可以访问 Docker Hub 的机器上拉取镜像(即不登服务器在自己电脑上用docker拉取)

2. 导出镜像为 tar 文件

3. 将 tar 文件传输到目标服务器(这里需要和服务器在一个局域网内,就是连服务器时登录内网)

4. 在目标服务器上加载镜像

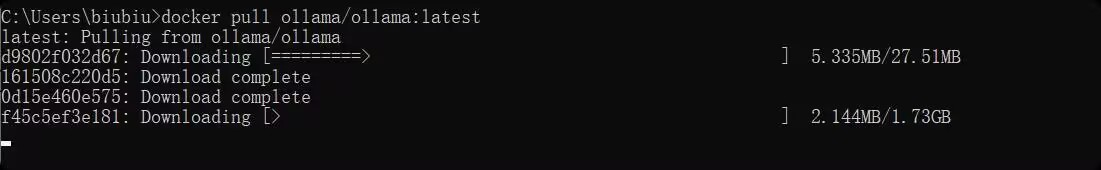

1. 在一台可以访问 Docker Hub 的机器上拉取镜像(即不登服务器在自己电脑上用docker拉取)

操作步骤:

确保你有一台能够正常访问 Docker Hub 的机器(例如你的本地电脑或其他服务器)。

使用以下命令从 Docker Hub 拉取 ollama/ollama 镜像:

docker pull ollama/ollama

验证是否成功:

检查镜像是否已经成功拉取到本地:

docker images2. 导出镜像为 tar 文件

操作步骤:

使用 docker save 命令将镜像导出为一个 .tar 文件:

docker save -o ollama.tar ollama/ollama检查当前目录下是否生成了 ollama.tar 文件:

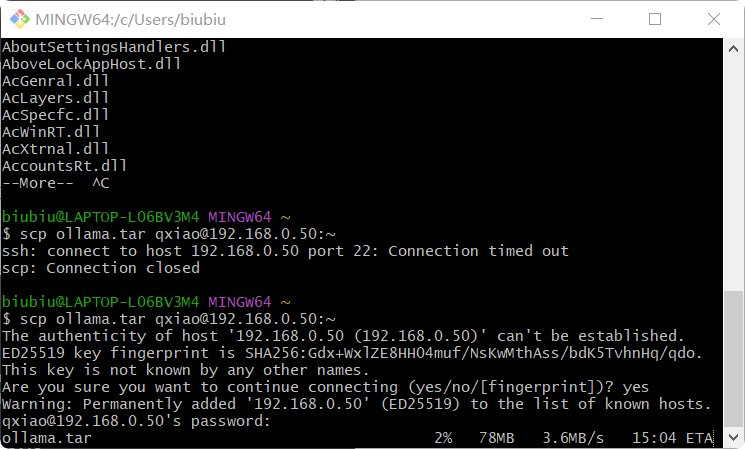

ls -lh ollama.tar3. 将 tar 文件传输到目标服务器(这里需要和服务器在一个局域网内,就是连服务器时登录内网)

操作步骤:

使用 scp 命令将 ollama.tar 文件从当前机器传输到目标服务器:

如果你不知道目标服务器的路径,可以直接传到用户的家目录:

scp ollama.tar qxiao@lab10x3090:~

登录到目标服务器,检查文件是否已成功传输(这里开始在服务器上操作):

ls -lh ~/ollama.tar4. 在目标服务器上加载镜像

操作步骤:

登录到目标服务器(如果尚未登录)。

使用 docker load 命令加载 .tar 文件中的镜像:

docker load -i ollama.tar验证是否成功:

检查镜像是否已成功加载到目标服务器:

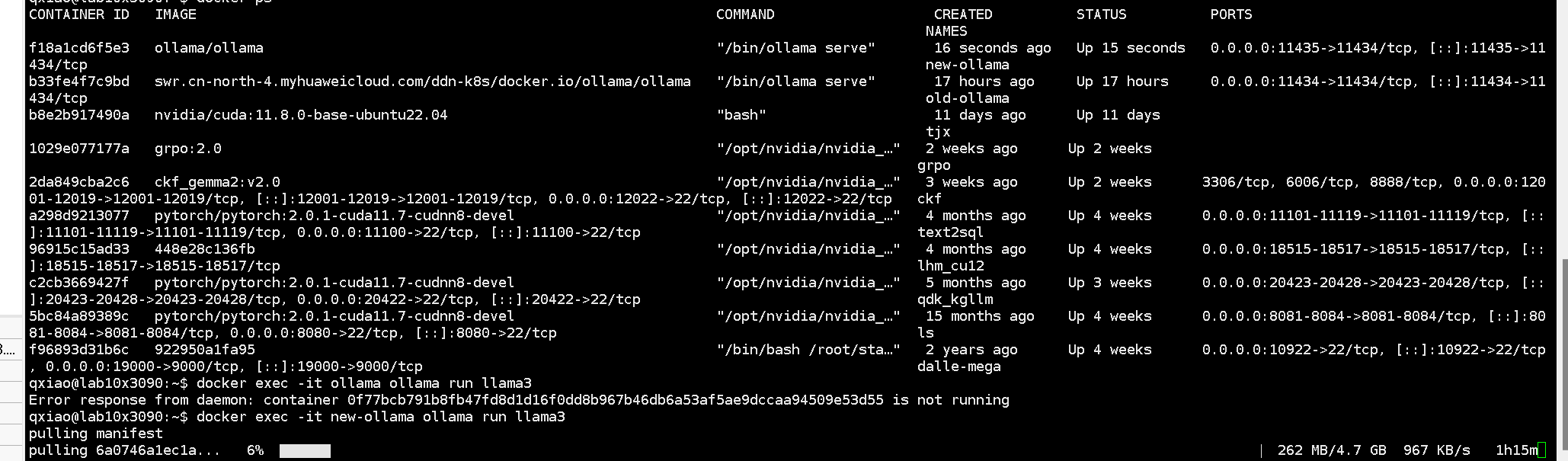

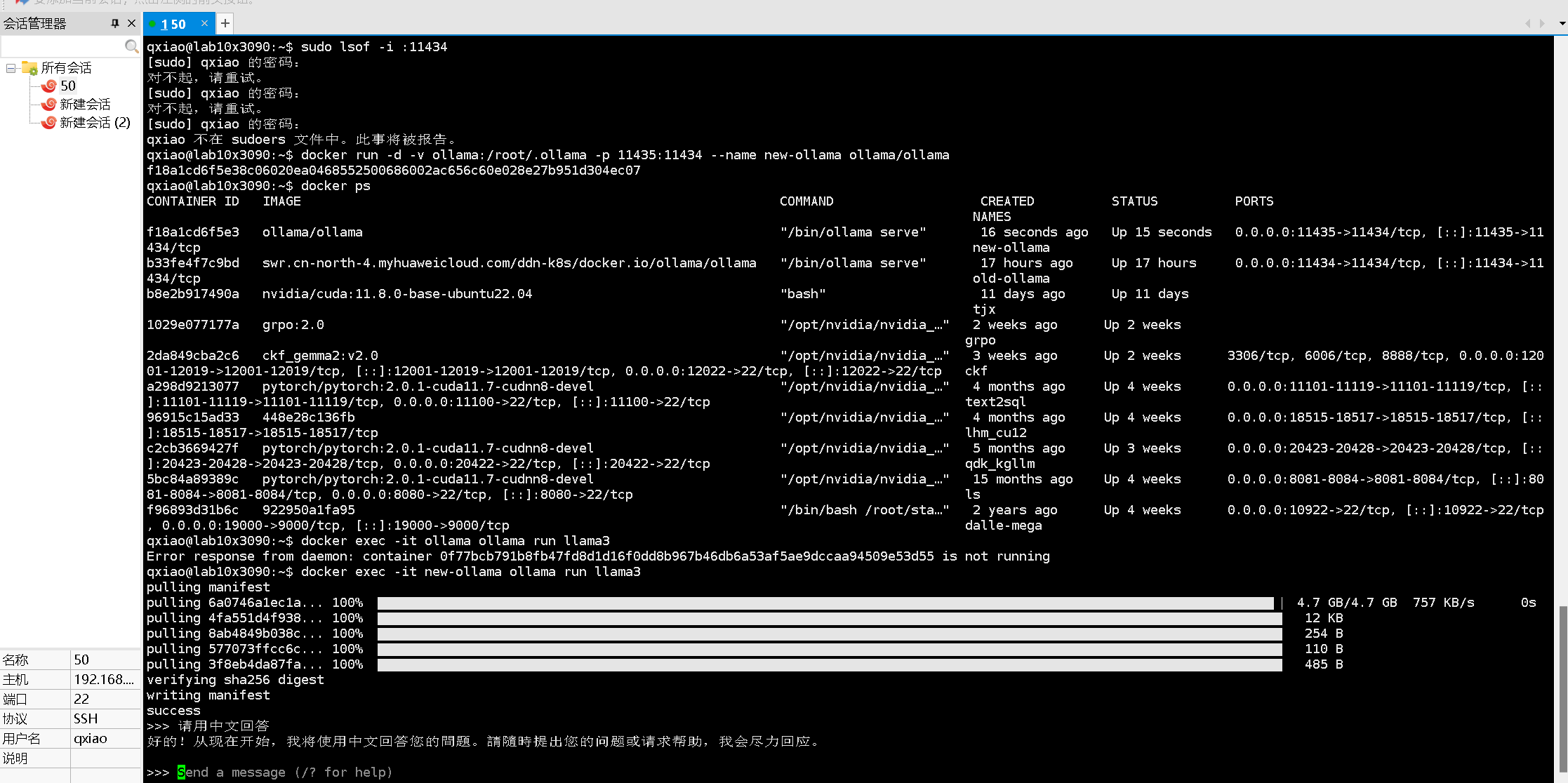

docker images加载镜像后,使用以下命令运行容器:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama最后进入容器拉取运行模型(可以根据自己需求拉取70B或者小一点的,(我这里是之前还有一个ollama镜像冲突了所以改了名字new)):

docker exec -it ollama ollama run llama3

最后这样就成功部署啦!(完结撒花)

新手小白参考csdn上其他博主完成,开始接到这个小任务连docker怎么用完全不知道,最开始是直接用官方ollama指令下载,实在太慢了根本不行。还有就是一直权限限制,在王师兄的指导下才使用docker再不断尝试才成功。真的十分感谢王师兄的耐心解答!还有我自己电脑docker也一直有问题启动不了,同样非常感谢biubiu帮忙拉取打包上传。最后不得不感谢通义大模型帮我分析解决问题,赞!

下一步尝试微调大模型,争取调教出更拽的霸道总裁。哈哈哈哈,敬请期待……