小白也能自己部署deepseekR1满血版,观文千篇,不如动手一遍。将deepseek部署在服务器上,多设备公用教程,主要涉及OllamaAPI_URL和秘钥设置

CherryStudio使用互联网调用自己的服务器ollama部署的deepseek教程

概述:

优势:cherrystudio可以本地部署自己的知识库。

截止20250210的缺点:不支持联网检索功能。

本文主要讲述如何在办公室电脑上安装的cherryStudio使用自己的服务器上部署的deepseek。

涉及内容有:

ollamaAPI地址是什么?

ollama秘钥的生成

Ollama模型的添加

具体步骤

第一步:下载和安装CherryStudio。

在使用者电脑上,安装cherry studio。https://cherry-ai.com/

第二步:下载和安装ollama。

在自己的服务器上部署ollama。(本文已省略)

第三步:启动ollama服务,设置为24小时运行模式。(本文已省略)。查看ollama运行状态命令“”

第四步:下载大模型文件。

在xshell中,联机服务器,使用“./ollama pull 模型名称”命令,将deepseek模型下载到服务器上。

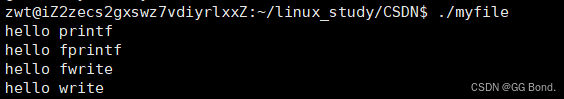

第五步:运行并检测大模型文件。

在ollama安装地址后输入“./ollama run 模型名称”,如 ./ollama run deepseek-r1:7b. 检测模型是否成功运行。